使用 LangChain、Milvus、NVIDIA BGE-M3 和 nomic-embed-text-v1.5 构建 RAG 聊天机器人

什么是 RAG

检索增强生成(Retrieval-Augmented Generation,简称 RAG)正引领生成式 AI,尤其是对话式 AI 的新潮流。它将预训练的大语言模型(LLM,如 OpenAI 的 GPT)与存储于向量数据库(如 Milvus、Zilliz Cloud)中的外部知识源相结合,从而让模型输出更准确、更具上下文相关性,并且能够及时融合最新信息。 一个完整的 RAG 系统通常包含以下四大核心组件:

- 向量数据库:用于存储与检索向量化后的知识;

- 嵌入模型:将文本转为向量表示,为后续的相似度搜索提供支持;

- 大语言模型(LLM):根据检索到的上下文和用户提问生成回答;

- 框架:负责将上述组件串联成可用的应用。

核心组件说明

本教程将带你在 Python 环境下,借助以下组件一步步搭建一个初级的 RAG 聊天机器人:

- LangChain: 一个开源框架,帮助你协调大语言模型、向量数据库、嵌入模型等之间的交互,使集成检索增强生成(RAG)管道变得更容易。

- Milvus: 一个开源的向量数据库,专门用于高效地存储、索引和搜索大规模向量嵌入,非常适合用于检索增强生成(RAG)、语义搜索和推荐系统等场景。如果您需要更具扩展性的解决方案,或不想管理自己的基础设施,我们推荐使用 Zilliz Cloud,这是一个基于开源项目 Milvus构建的全托管向量数据库服务,并提供支持最多 100 万个向量的免费套餐。

- NVIDIA BGE-M3: NVIDIA BGE-M3 是一款尖端的语言模型,旨在生成类人文本,适用于多种自然语言处理任务。它的优势在于能够产生连贯且具有上下文相关性的响应,使其非常适合用于聊天机器人、内容创作和虚拟助手等应用。BGE-M3 在理解细微的输入方面表现出色,为用户提供高度准确且引人入胜的互动,从而增强多个行业中的自动化沟通系统。

- nomic-embed-text-v1.5: 该模型专注于生成高质量的文本嵌入,捕捉语义意义和上下文细微差别。其优势在于促进高效的相似性搜索和信息检索任务。非常适合在推荐系统、语义搜索和自然语言理解等应用中,提高各种NLP项目的性能。

完成本教程后,你将拥有一个能够基于自定义知识库回答问题的完整聊天机器人。

注意事项: 使用专有模型前请确保已获取有效 API 密钥。

实战:搭建 RAG 聊天机器人

第 1 步:安装并配置 LangChain

%pip install --quiet --upgrade langchain-text-splitters langchain-community langgraph

第 2 步:安装并配置 NVIDIA BGE-M3

pip install -qU "langchain-nvidia-ai-endpoints"

import getpass

import os

if not os.environ.get("NVIDIA_API_KEY"):

os.environ["NVIDIA_API_KEY"] = getpass.getpass("Enter API key for NVIDIA: ")

from langchain.chat_models import init_chat_model

llm = init_chat_model("baai/bge-m3", model_provider="nvidia")

第 3 步:安装并配置 nomic-embed-text-v1.5

pip install -qU langchain-nomic

import getpass

import os

if not os.environ.get("NOMIC_API_KEY"):

os.environ["NOMIC_API_KEY"] = getpass.getpass("Enter API key for Nomic: ")

from langchain_nomic import NomicEmbeddings

embeddings = NomicEmbeddings(model="nomic-embed-text-v1.5")

第 4 步:安装并配置 Milvus

pip install -qU langchain-milvus

from langchain_milvus import Milvus

vector_store = Milvus(embedding_function=embeddings)

第 5 步:正式构建 RAG 聊天机器人

在设置好所有组件之后,我们来搭建一个简单的聊天机器人。我们将使用 Milvus介绍文档 作为私有知识库。你可以用你自己的数据集替换它,来定制你自己的 RAG 聊天机器人。

import bs4

from langchain import hub

from langchain_community.document_loaders import WebBaseLoader

from langchain_core.documents import Document

from langchain_text_splitters import RecursiveCharacterTextSplitter

from langgraph.graph import START, StateGraph

from typing_extensions import List, TypedDict

# 加载并拆分博客内容

loader = WebBaseLoader(

web_paths=("https://milvus.io/docs/overview.md",),

bs_kwargs=dict(

parse_only=bs4.SoupStrainer(

class_=("doc-style doc-post-content")

)

),

)

docs = loader.load()

text_splitter = RecursiveCharacterTextSplitter(chunk_size=1000, chunk_overlap=200)

all_splits = text_splitter.split_documents(docs)

# 索引分块

_ = vector_store.add_documents(documents=all_splits)

# Define prompt for question-answering

prompt = hub.pull("rlm/rag-prompt")

# 定义应用状态

class State(TypedDict):

question: str

context: List[Document]

answer: str

# 定义应用步骤

def retrieve(state: State):

retrieved_docs = vector_store.similarity_search(state["question"])

return {"context": retrieved_docs}

def generate(state: State):

docs_content = "\n\n".join(doc.page_content for doc in state["context"])

messages = prompt.invoke({"question": state["question"], "context": docs_content})

response = llm.invoke(messages)

return {"answer": response.content}

# 编译应用并测试

graph_builder = StateGraph(State).add_sequence([retrieve, generate])

graph_builder.add_edge(START, "retrieve")

graph = graph_builder.compile()

测试聊天机器人

Yeah! You've built your own chatbot. Let's ask the chatbot a question.

response = graph.invoke({"question": "What data types does Milvus support?"})

print(response["answer"])

示例输出

Milvus 支持多种数据类型,包括稀疏向量、二进制向量、JSON 和数组。此外,它还支持常见的数值类型和字符类型,使其能够满足不同的数据建模需求。这使得用户能够高效地管理非结构化或多模态数据。

优化小贴士

在搭建 RAG 系统时,合理调优能显著提升性能与效率。下面为各组件提供一些实用建议:

LangChain 优化建议

为了优化 LangChain,需要通过高效地构建链路和代理来减少工作流程中的冗余操作。使用缓存避免重复计算,从而加快系统速度,并尝试采用模块化设计,确保模型或数据库等组件能够轻松替换。这将提供灵活性和效率,使您能够快速扩展系统,而无需不必要的延迟或复杂性。

Milvus 优化建议

Milvus 作为一个高效的向量数据库,在 RAG 系统的检索任务中发挥着关键作用。要优化其性能,应确保构建合适的索引,以平衡速度和准确性;对于响应时间至关重要的场景,可考虑使用 HNSW(Hierarchical Navigable Small World)进行高效的最近邻搜索。根据使用模式对数据进行分区,有助于提升查询性能并减少加载时间,从而提高系统的可扩展性。根据查询频率定期监控并调整缓存设置,以避免数据检索时出现延迟。向量插入时采用批处理模式,可以减少数据库锁争用,提高整体吞吐量。此外,通过调整向量的维度来优化模型参数:更高的维度可以提升检索准确性,但可能增加搜索时间,因此需根据具体用例和硬件条件找到最佳平衡点。

NVIDIA BGE-M3 优化建议

为了在检索增强生成(RAG)设置中优化 NVIDIA BGE-M3,确保您的数据检索系统经过精细调优,以实现可重用性和相关性——考虑实施缓存机制以存储频繁访问的文档。此外,实验检索参数,例如最近邻搜索中的 k 值,可以为您的特定任务产生更好的结果。利用混合精度训练来提高吞吐量并减少内存使用,同时不影响模型性能。定期通过验证测试监控和微调超参数,以实现速度和准确性之间的最佳平衡。最后,利用 NVIDIA 的 TensorRT 或 ONNX 优化工具进行模型部署,以最大化推理效率。

nomic-embed-text-v1.5 优化建议

nomic-embed-text-v1.5 是一个全面的嵌入模型,在各种文本检索场景中表现出色。在进行嵌入之前,优化文本预处理,去除停用词和冗余信息,以提高存储效率。使用层级索引结构管理大规模数据集中的嵌入,提高检索速度。利用余弦相似度过滤在查询后细化搜索结果。为了实现经济高效的扩展,一次对多个文档进行批量嵌入,并将嵌入存储在像 Milvus 或 FAISS 这样的分布式向量数据库中。如果处理快速变化的数据,实施增量索引而不是完全重新处理,以节省计算时间。定期通过与基准数据集验证,监测嵌入质量以确保相关性。

通过系统性实施这些优化方案,RAG 系统将在响应速度、结果准确率、资源利用率等维度获得全面提升。 AI 技术迭代迅速,建议定期进行压力测试与架构调优,持续跟踪最新优化方案,确保系统在技术发展中始终保持竞争优势。

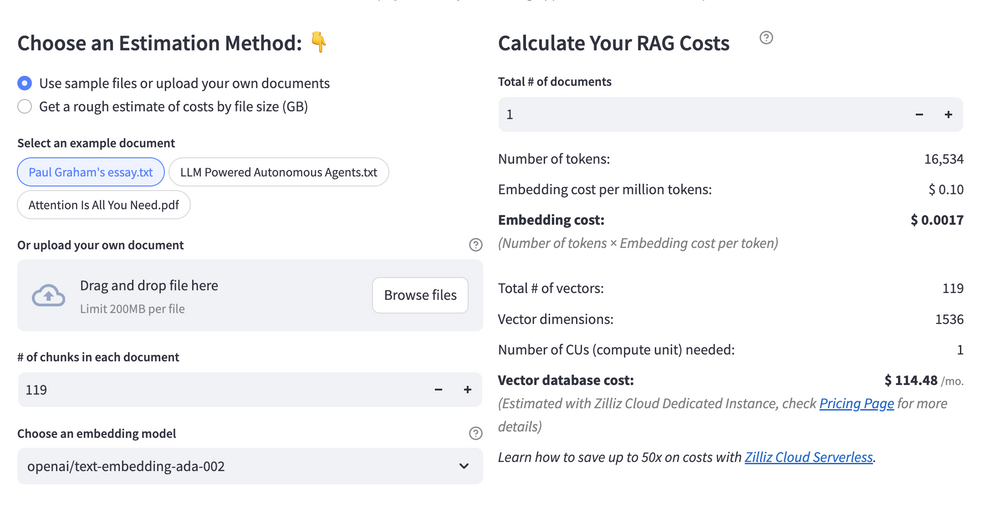

RAG 成本计算器

估算 RAG 成本时,需要分析向量存储、计算资源和 API 使用等方面的开销。主要成本驱动因素包括向量数据库查询、嵌入生成和 LLM 推理。RAG 成本计算器是一款免费的在线工具,可快速估算构建 RAG 的费用,涵盖切块(chunking)、嵌入、向量存储/搜索和 LLM 生成。能帮助你发现节省费用的机会,最高可通过无服务器方案在向量存储成本上实现 10 倍降本。

Calculate your RAG cost

Calculate your RAG cost

收获与总结

通过深入学习本教程,您已解锁将前沿工具结合起来,从零开始构建强大RAG系统的能力!您了解到,LangChain作为粘合剂,无缝协调各个组件之间的交互。高性能向量数据库Milvus快速存储和检索嵌入,确保您的系统轻松处理复杂查询。与此同时,NVIDIA的BGE-M3和nomic-embed-text-v1.5嵌入模型发挥其魔力,将原始文本转换为丰富的数值表示,捕捉意义和语境。所有这些部分共同形成一个动态管道,LangChain将问题路由到您的大型语言模型(LLM),使用这些强大的嵌入从Milvus中检索相关的上下文,并合成准确、具有上下文意识的答案。您看到每个工具的独特优势——如BGE-M3的多语言能力或Milvus的可扩展性——如何结合创造出超越部分之和的整体!

但等等,还有更多!教程不仅仅停留在集成上——它还为您提供了优化技巧,以微调性能,如通过智能索引策略平衡速度和准确性,或为您的用例选择合适的嵌入模型。您甚至还看到了实用工具,比如免费的RAG成本计算器,用于估算开支并优化资源使用。现在,借助这个工具包,您已准备好构建更智能的应用程序,无论是超响应的聊天机器人、研究助手,还是企业级知识中心。人工智能驱动解决方案的未来掌握在您手中——所以尽情实验,无畏地调整,让您的创造力尽情释放。世界需要您的创新,而开始的最佳时机就是现在。祝您构建愉快!🚀

欢迎反馈!

我们很期待听到你的使用心得与建议! 🌟 你可以:

- 在下方留言;

- 加入 Milvus Discord 社区,与全球 AI 爱好者一起交流。 如果你觉得本教程对你有帮助,别忘了给 Milvus GitHub 仓库点个 ⭐,这将激励我们不断创作!💖