使用Timeplus Proton在Kafka中处理流数据

在2024年4月,Timeplus的联合创始人Jove Zhong在西雅图非结构化数据聚会上发表了题为“使用Timeplus Proton在Kafka中处理流数据”的演讲。作为数据流和实时处理的专家,Jove全面概述了Timeplus如何与Kafka集成以处理实时数据,同时还进行了既引人入胜又具有教育意义的现场演示。让我们深入了解这次富有洞见的会议的关键点和见解。

Jove Zhong演讲的YouTube回放链接:在YouTube上观看演讲

Timeplus及其实时能力

Jove Zhong是一位软件工程大师。如果你不相信我,可以查看他的成绩记录。他是Timeplus的联合创始人兼产品负责人,曾任Splunk工程总监,拥有17项专利和4项AWS认证。哦,自2010年以来,他一直是一位“世界级的父亲”。Jove在父职和商业领导之间画了迷人的平行线,表明抚养孩子和管理公司比你想象的有更多的共同点。

有了这些背景,让我们深入了解Jove关于“使用Timeplus Proton在Kafka中处理流数据”的演讲。

总部位于加利福尼亚州圣克拉拉的Timeplus正在用其创新的流SQL数据库和实时分析平台彻底改变实时数据处理。在顶级风险投资家和技术专家的支持下,Timeplus提供开源和商业版本,使实时数据流的有效管理和处理成为可能。其突出特点包括动态仪表板和基于SQL的处理,使实时数据操作易于访问和用户友好。

Timeplus Proton是Timeplus的核心引擎,是像ksqlDB和Apache Flink这样的平台的强大替代品。它轻量级,用C++编写,并针对性能进行了优化。凭借流ETL、窗口函数和高基数聚合等功能,Proton使开发人员能够高效地解决流数据处理挑战。该平台支持多种数据源,包括Apache Kafka、Confluent Cloud和Redpanda,并允许实时洞察和警报。

无论是金融科技、人工智能、机器学习还是可观测性,Timeplus都提供了端到端的能力,帮助数据团队快速直观地处理流和历史数据。这是一个简单、强大且成本效益高的解决方案,专为各种规模和行业的组织设计。

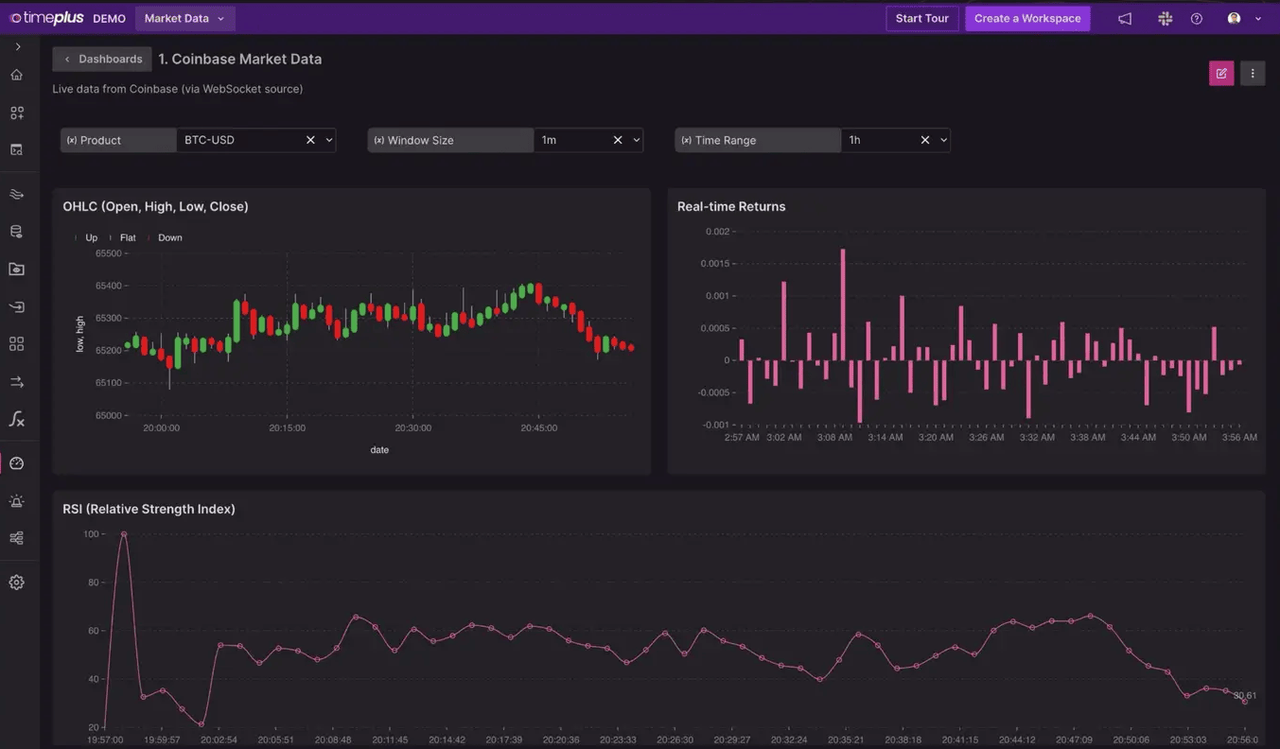

现场演示:实时比特币价格监控

为了开始,Jove通过展示实时比特币价格源,展示了Timeplus的实时能力。这个演示不仅仅是技术实力的展示,也是展示Timeplus如何比传统的来源如Google更快地处理和显示数据的例证。当Jove将实时源与Google的进行比较,突出Timeplus的优越性能时,观众被深深吸引。

Kafka:实时数据流的支柱

Jove深入讲解了Kafka,解释了其架构和功能。Kafka是一个强大的开源事件流平台,用于处理各种数据类型和管理分布式计算环境。用Java和Scala编写的Kafka旨在处理高吞吐量和低延迟的实时数据源。Kafka受到超过80%的财富100强公司的信任,包括高盛、塔吉特和思科等行业巨头,以其可靠性和性能而闻名。

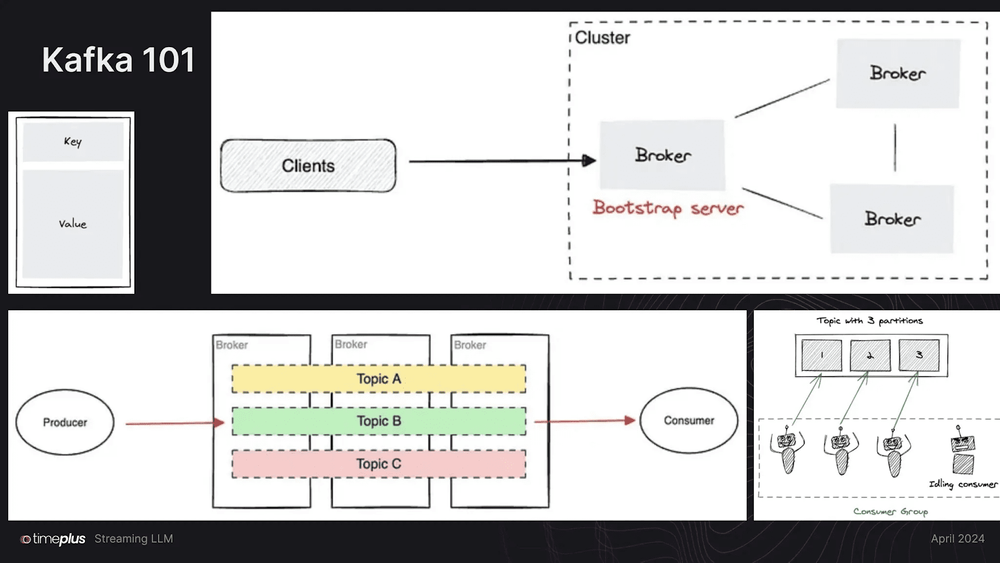

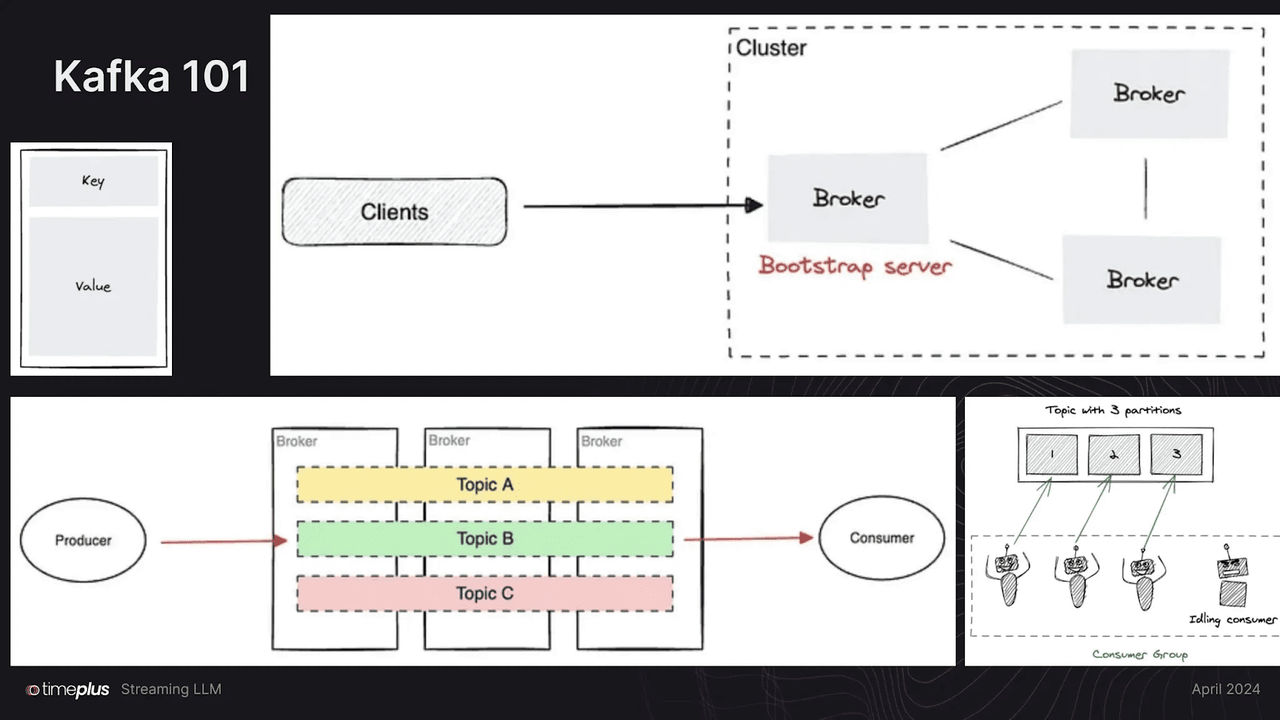

理解Kafka的架构

Kafka作为一个分布式数据流平台,能够每秒处理数百万事件。通过以下图表可视化Kafka的架构,Jove展示了平台处理高吞吐量和低延迟的实时数据源的能力,使其成为现代数据流需求的强大工具。图表解释了生产者、消费者和代理如何协同工作,确保数据被有效处理和传递。他还讨论了Kafka的复制和分区策略,这些策略提供了容错性和可扩展性。

Kafka作为一个由服务器和客户端组成的分布式系统,通过高性能的TCP网络协议进行通信。它可以在裸机硬件、虚拟机和容器中部署,既可以在本地也可以在云环境中。

Kafka的架构,如图表所示,由几个关键组件组成

客户端和代理:

Kafka作为一个由客户端和代理组成的分布式系统运行。客户端是生成和消费消息的应用程序。代理是存储和转发这些消息的服务器。图表显示了客户端如何连接到代理,代理作为引导服务器将数据路由到集群中的其他代理。

生产者和消费者:

生产者负责将数据发送到Kafka主题,而消费者从这些主题读取数据。图表展示了生产者如何将消息发送到不同主题(主题A、主题B、主题C)跨多个代理。然后消费者从这些主题读取,确保数据被高效处理和传递。

主题和分区:

Kafka主题被划分为分区,这允许数据的并行处理。每个分区在多个代理中复制,以确保容错。图表显示了一个主题有三个分区被不同的消费者消费,展示了Kafka如何分发负载并保持高可用性。

可扩展性和容错性:

Kafka集群具有高度可扩展性,可以跨越多个数据中心或云区域。架构支持弹性扩展和收缩,确保在不丢失数据的情况下持续运行。如果代理失败,系统可以通过将数据重定向到其他代理来恢复。

流LLM和向量数据库

演讲的很大一部分专门探讨了数据流如何与大型语言模型(LLMs)和向量数据库集成。Jove强调了这些集成的潜力,可以增强AI应用,使数据处理更加高效和准确。将流数据与AI模型的融合可以显著提高各种应用的响应性和智能性。

最近,Zilliz Cloud和Apache Flink®的Confluent Cloud宣布了合作伙伴关系,进一步展示了这一概念。利用这一点,您可以使用Kafka和Flink构建实时GenAI应用程序;企业可以创建实时数据管道,这些管道流入像Milvus这样的向量数据库。这种设置使开发高级AI应用程序成为可能,例如实时语义搜索和检索增强生成(RAG)。通过实时数据处理,LLMs可以访问最新信息,确保从企业搜索到电子商务中的个性化推荐等各种应用程序中的准确和及时响应。

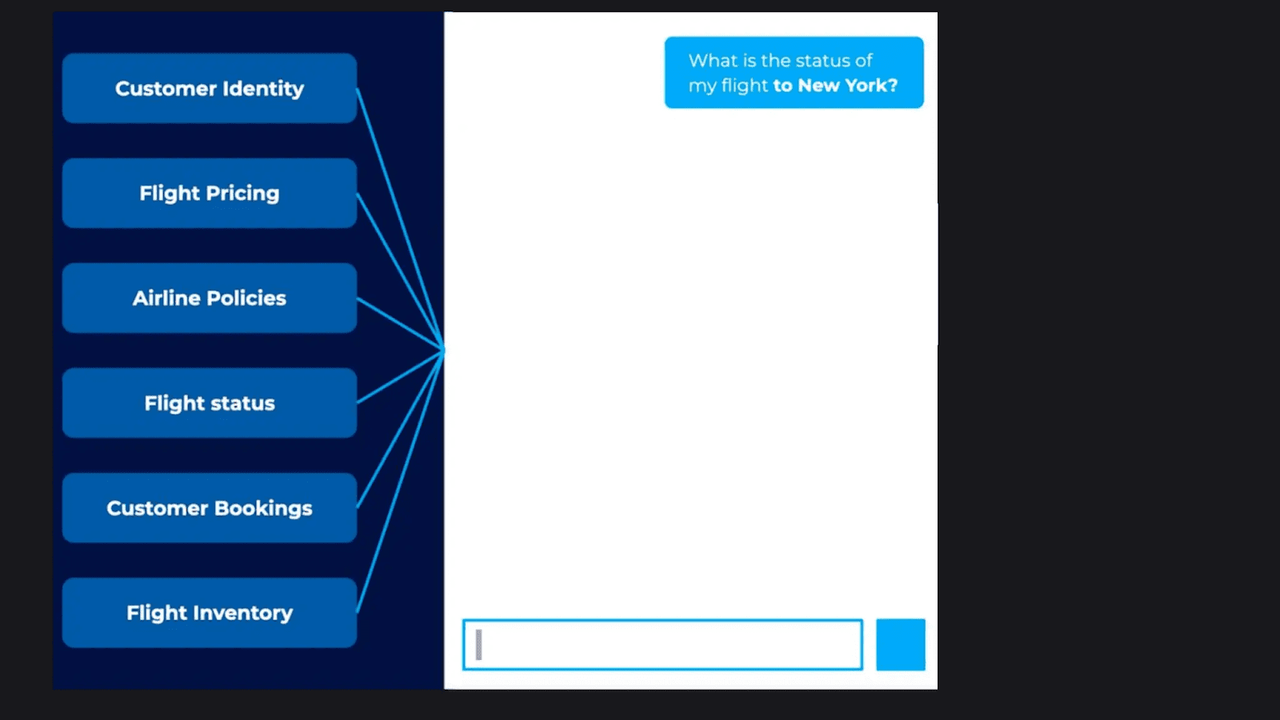

实际应用:AI驱动的聊天机器人

Jove讨论的一个实际应用是使用实时数据的AI驱动聊天机器人。通过利用实时数据流,这些聊天机器人可以提供最新信息,例如航班状态更新。例如,聊天机器人可以即时通知用户航班延误并建议替代航班,展示了实时数据处理的实际好处。

112.3.png

112.3.png

Jove给出了一个例子,假设你正在与航班状态机器人聊天:

用户:“我飞往纽约的航班状态是什么?”

聊天机器人:“你的航班延误了2小时。”

用户:“我可以找到另一班让我更快到达的航班吗?”

聊天机器人:“是的,有一班替代航班还有一张座位。它将花费你1500美元,但你将准时到达。”

用户:“太好了,为我预订它。”

在这个场景中,聊天机器人利用Kafka的实时数据流提供最新的航班信息。它不仅告知用户延误情况,还实时检查可用航班、座位和价格。然后聊天机器人将这些信息呈现给用户,使他们能够快速做出明智的决策。这个例子展示了Kafka的实时数据处理能力如何增强AI驱动聊天机器人的功能和响应性,使它们成为寻求即时和准确信息的用户的重要工具。

将Timeplus与向量数据库集成

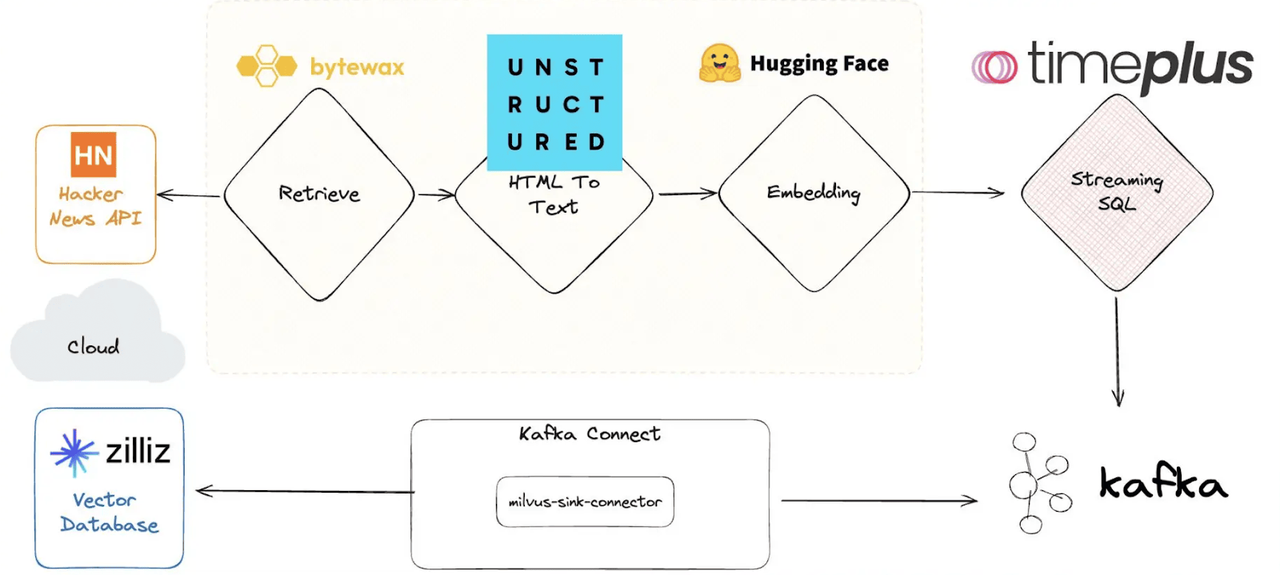

Jove的演示继续展示了Timeplus和向量数据库(即Milvus)的令人印象深刻的集成,展示了如何实时处理和查询Hacker News的数据。这个过程在下图中进行了说明。工作流程从检索Hacker News API的数据开始,然后使用Bytewax将HTML转换为文本。文本随后通过Hugging Face嵌入,并通过Timeplus的SQL功能进行流式传输。数据通过Milvus的sink连接器连接到Kafka,实现在Milvus向量数据库中的实时查询和处理。

112.4.png

112.4.png

他通过一个具体的例子向我们展示了这种集成的强大能力。

想象一下,你正在处理Hacker News的数据。让我们获取Hacker News的最新数据。使用Timeplus,我们可以实时流式传输这些数据。Jove输入一个命令,几秒钟内,就会出现一串Hacker News的帖子。现在,假设我们想要找到所有提到“dogfooding”的帖子。我们可以在这个非结构化数据上运行一个复杂的查询。他输入查询,系统几乎立即返回了相关帖子的列表。

但我们不会就此止步。让我们看看这些帖子的情感分析。通过另一个命令,数据被处理,情感分析被显示出来,显示哪些帖子是积极的、消极的或中性的。

这就是将Timeplus与向量数据库集成的力量。我们可以处理大量的非结构化数据,运行复杂的查询,并实时提取有价值的见解。

除了Timeplus,Milvus还通过Confluent Kafka Connector提供与Kafka的集成,实现向Milvus或Zilliz Cloud的实时向量数据流式传输。这种设置允许进行实时语义搜索和相似性搜索,增强了从流数据中立即获得洞察的能力。

为了快速了解,下表列出了本文讨论的一些重要产品及其描述和用例。

| 产品 | 描述 | 用例 |

| Timeplus | 一个具有强大流式SQL能力的实时分析平台 | 实时数据处理和分析 |

| Timeplus Proton | Timeplus的核心引擎轻量级,用C++编写,并针对性能进行了优化 | 流式ETL、窗口函数、高基数聚合 |

| Kafka | 分布式事件流平台,处理高吞吐量、低延迟的数据流 | 数据管道、流式分析、数据集成 |

| Confluent Kafka Connector | 用于将Kafka与Milvus和Zilliz Cloud集成的工具,实现实时向量数据流式传输 | 向量数据库的实时数据流式传输 |

| Apache Flink | 统一的流和批处理框架,与Confluent Cloud上的Kafka集成 | 高性能流处理 |

结论

Jove Zhong在西雅图非结构化数据聚会上的演讲是实时数据处理的大师课。从实践演示到深入探讨高级概念,Jove全面概述了Timeplus和Kafka如何塑造数据分析的未来。演讲以对流式SQL和实时处理未来的展望结束。Jove强调了这些技术在构建更智能、更响应的AI系统中日益增长的重要性。实时处理数据并立即做出决策的能力在许多行业中变得至关重要,从金融到医疗保健。

对于那些对进一步探索这些技术感兴趣的人,演讲和演示幻灯片的完整回放都是可用的。

技术干货

一次解决三大成本问题,升级后的 Zilliz Cloud 如何造福 AIGC 开发者?

对于应用开发而言,成本问题向来是企业和开发者关注的重点,更迭迅速、变化莫测的 AIGC 时代更是如此。这里的成本既指软件开发成本,也包括硬件成本、维护成本。Zilliz Cloud 可以一次性解决这三大问题,帮助开发者降低开发成本、优化硬件成本、减少维护成本。

2023-7-6

技术干货

我决定给 ChatGPT 做个缓存层 >>> Hello GPTCache

我们从自己的开源项目 Milvus 和一顿没有任何目的午饭中分别获得了灵感,做出了 OSSChat、GPTCache。在这个过程中,我们也在不断接受「从 0 到 1」的考验。作为茫茫 AI 领域开发者和探索者中的一员,我很愿意与诸位分享这背后的故事、逻辑和设计思考,希望大家能避坑避雷、有所收获。

2023-4-14

技术干货

如何在 Jupyter Notebook 用一行代码启动 Milvus?

本文将基于 Milvus Lite,为大家介绍如何在 Jupyter Notebook 中使用向量数据库。

2023-6-12