利用 Milvus 在 AI 系统中驾驭生成性反馈循环

生成性反馈循环是一个循环过程,AI 模型生成的输出被反馈到系统中作为训练数据。这使得模型能够随着时间的推移不断学习和提高其能力。这个循环重复进行,允许 AI 逐步优化其结果。

大型语言模型(LLMs)可以从生成性反馈循环中显著受益。LLMs 在大量文本数据上进行训练,使它们能够理解和生成类似人类的文本。然而,它们的基础知识是静态的,它们不会自动从新信息中学习。这就是 Milvus 的用武之地。

Milvus 是一个开源向量数据库,设计用于实时存储、索引和搜索大量向量数据。在 LLMs 的背景下,Milvus 可以高效地存储和检索编码文本数据语义的向量表示。将 Milvus 与 LLMs 集成到生成性反馈循环中,允许我们创建一个不断学习和改进的动态系统。

为了更好地理解这些组件如何协同工作,让我们首先看看 AI 和机器学习中生成性反馈循环的概念。

理解生成性反馈循环 在 AI 和机器学习的背景下,反馈循环是一种利用模型的输出数据来改进模型本身的机制。这种迭代过程允许模型不断学习和完善其性能。参与生成性反馈循环的核心要素包括:

- 模型训练:初始阶段涉及使用标记示例数据集训练 AI 模型。此数据集为模型提供了学习数据中潜在模式和关系的基础。

- 模型输出:一旦训练完成,模型就会生成新的输出,这些可以是预测、分类或创造性文本格式等。

- 评估和反馈:然后根据一组预定义的标准评估生成的输出。这种评估可能涉及人类专家评估其质量和准确性,或与真实数据进行比较。

- 数据集成:评估后的输出和相关的反馈数据随后被整合到训练数据集中。这个丰富的数据集使模型能够从过去的性能中学习,并在后续迭代中完善其输出生成过程。

生成性反馈循环在确保 AI 系统中模型输出的持续改进中至关重要。以下是这些循环如何促进这种持续改进的具体好处:

适应新数据:

循环将新数据输入和交互纳入训练数据。

这允许模型适应不断演变的模式和趋势,提高未来输出的相关性和准确性。

减少偏见和错误:

- 循环有助于识别和减轻初始训练数据中的偏见。

- 人类评估或真实数据可以标记偏离期望结果的输出。

- 这有助于调整训练数据和模型参数,随着时间的推移减少偏见和错误。

个性化模型输出:

用户反馈或偏好可以整合到反馈循环中。

模型个性化输出,以更好地满足特定用户需求和背景。

例如,产品描述模型可以根据用户点击率进行优化,从而产生更具吸引力和说服力的描述。

增强创造力和创新:

反馈循环使模型能够在生成性 AI 应用中探索新的创意途径。

模型分析成功的过去输出和用户偏好。

这引导模型生成更具创新性和相关性的创意内容。

这种持续学习促进了创意探索和完善的循环。

现在,让我们看看反馈循环如何增强 LLMs。

反馈循环在 LLMs 中的作用 大型语言模型(LLMs)是先进的 AI 系统,能够理解和生成类似人类的文本。它们在庞大的数据集上进行训练,使它们能够执行从翻译到内容创建等各种与语言相关的任务。它们理解上下文和细微差别的能力使它们能够参与对话、回答问题,甚至模仿某些写作风格。

反馈循环对于提高 LLMs 的性能至关重要。它们使用模型生成的输出作为进一步学习的输入,允许模型完善其预测和文本生成。以下是反馈循环如何增强 LLMs 的方法:

- 持续学习:通过纳入用户反馈,LLMs 可以从它们的交互中学习。这可以是显式的,如更正或建议,也可以是隐式的,例如用户更多参与哪些响应。

- 适应用户偏好:随着时间的推移,反馈循环帮助 LLMs 适应个别用户偏好,定制生成文本的风格和内容以满足用户期望。

- 错误更正:当识别出错误时,反馈循环使 LLMs 能够调整其内部参数,减少重复相同错误的可能性。

- 预测准确性:通过分析哪些预测成功以及哪些没有,LLMs 可以提高其理解和预测用户需求的准确性。

- 生成能力:反馈循环可以指导 LLMs 生成更具创造性和多样性的内容,无论是写故事、写诗还是创建信息性文章。

通过利用反馈循环,LLMs 更加高效、准确、个性化和用户友好。这是一段持续改进的旅程,旨在为用户提供一种既直观又明显人性化的体验。

集成 Milvus 以增强数据处理 Milvus 是一个高性能的分布式向量数据库,特别适用于管理大规模向量数据,在 LLMs 的反馈循环场景中管理大量数据至关重要。以下是 Milvus 的一些关键特性,使其适合此类应用:

- 向量嵌入:Milvus 专门处理从机器学习模型派生的数值表示向量嵌入。这些嵌入封装了非结构化数据的语义含义,允许进行细致的搜索,捕捉数据的本质。

- 高效查询处理:它支持超出简单向量相似性搜索的高级查询处理。这意味着它可以处理动态数据以进行快速更新,同时确保高效的查询处理,这对于持续学习和适应的 LLMs 至关重要。

- 可扩展性和可用性:Milvus 跨多个节点分发数据以实现可扩展性和高可用性。这对于数据量可能随着新信息的不断整合而迅速增长的反馈循环非常重要。

- 异构计算:该系统针对现代 CPU 和 GPU 的异构计算平台进行优化,这有利于 LLMs 训练和响应生成中涉及的计算密集型任务。

- 易于使用的接口:Milvus 提供易于使用的应用接口,包括 SDK 和 RESTful API,便于与 LLMs 和其他 AI 应用集成。

在支持动态 LLMs 训练和响应生成所需的高效数据索引和检索方面,Milvus 提供:

- 检索增强生成(RAG):Milvus 可用于构建 RAG 系统,将检索系统与生成模型相结合。这允许基于检索的文档生成新文本,是动态 LLMs 训练的关键组成部分。

- 向量存储:它设置了一个向量存储来保存向量嵌入,这对于文本到文本的相似性搜索至关重要。此功能使 LLMs 在准备答案时能够查看文档,从而提高响应生成的质量。

- 索引和搜索框架:Milvus 与 NVIDIA Merlin 等框架集成,提供高效的向量数据库索引和搜索功能。这些对于推荐工作流程至关重要,可以应用于 LLMs 以提高预测和响应的准确性。

这些特性使 Milvus 成为增强 LLMs 数据处理能力的有力工具,特别是在使用反馈循环来完善预测和生成准确性的场景中。

接下来,让我们看看如何使用 Milvus 和 LLMs 设置生成性反馈系统。

使用 Milvus 和 LLMs 设置生成性反馈系统 我们将从安装所需包开始,如下所示。我们将使用 Anthropic 的 Claude 模型进行文本生成。有关安装 Milvus 的更多信息,请参阅官方文档:Milvus 文档。

shell

**# 安装 anthropic 包以使用 Anthropic LLM**_**pip install anthropic**_**# 安装 sentence-transformers 包进行文本嵌入**_**pip install sentence-transformers**

接下来,我们将按照以下步骤启动 Milvus 服务器:

- 从 milvus 包中导入 default_server 模块。

- 从 pymilvus 包中导入 connections 和 utility 模块。

- (可选)使用 default_server 的 cleanup() 方法清理任何先前的数据。

- 使用 default_server 的 start() 方法启动 Milvus 服务器。

- 使用 connections 的 connect() 方法连接到 Milvus 服务器,指定主机和端口。

- 使用 utility 的 get_server_version() 方法检查服务器是否就绪,打印服务器版本。 以下代码显示了我们执行的所有步骤。

# 检查服务器是否就绪,打印服务器版本**_**print(utility.get\_server\_version())**

接下来我们执行以下操作:

- 从 pymilvus 包中导入 MilvusClient 类。

- 使用 MilvusClient() 构造函数创建一个名为 client1 的 Milvus 客户端实例。

**# 创建 Milvus 客户端实例**_**client1 = MilvusClient()**

之后,我们创建一个模式和集合以及它们的索引参数。我们将集合命名为 taverns10。我们使用 pymilvus 如下所示。

vus import Collection, FieldSchema, CollectionSchema, DataType

dim=384, description="Vector embedding for semantic search") ]

定义相似性搜索的索引参数

index\_params = { "metric\_type": "IP", "index\_type": "HNSW", "params": {"M": 48, "efConstruction": 200} }

使用定义的字段和描述创建 CollectionSchema 对象

schema = CollectionSchema(fields=fields, description="LOTR Taverns")

使用指定的名称、模式和索引参数创建 Collection 对象

taverns10 = Collection(name="taverns10", schema=schema, index\_params=index\_params)

使用指定的索引参数在 "vector_embedding" 字段上创建索引

taverns10.create\_index("vector\_embedding", index\_params)

**现在我们将向数据库添加文档及其向量嵌入。我们将使用 claude opus 创建文档描述,然后使用 sentence transformers 创建它们的嵌入。首先,我们初始化 Anthropic 客户端和 sentence transformers 嵌入模型,如下所示:

**)**

**)**

接下来,我们创建一个生成函数,使用 claude opus 模型生成描述。然后我们使用这个函数生成描述,并创建嵌入,然后将它们添加到集合中。

**python**

现在我们已经创建了集合,并将向量嵌入添加到数据库中。要使用它,我们需要使用 load_collection 方法加载集合,如下所示:

**# 打印加载状态**_**print(res)**

输出

**{'state': \<LoadState: Loaded>}**

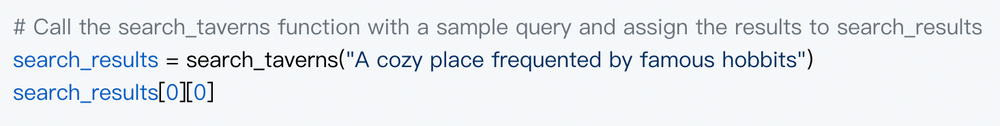

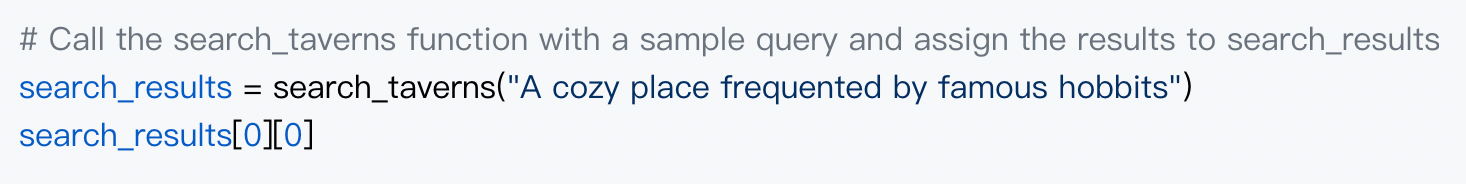

现在,让我们创建一个函数,使用任何输入查询执行语义搜索。我们如下所示执行该操作。

截屏2024-07-24 15.05.20.png

截屏2024-07-24 15.05.20.png

输出

it's a sanctuary where stories are shared, bonds are forged, and the spirit of adventure thrives, making it a true gem in the heart of Bree."}

我们得到了一个更接近我们期望的响应。我们可以使用这个响应来进一步优化响应,从而触发反馈循环。这可以有效地提高输出的准确性。

实际应用和好处 Milvus 通过启用用户-项目匹配的相似性搜索,增强了个性化推荐等 AI 应用,确保了定制内容的传递。自适应学习系统促进了教育资源的快速检索,并适应了个人学习节奏。对于实时内容生成,Milvus 的高效索引支持动态内容创建。

使用 Milvus 的好处包括可扩展性以处理不断增长的数据量、速度以实现即时查询响应,以及在查找最相关数据点方面的精度,使其成为 AI 驱动应用的强大支柱。

挑战和考虑因素 在 LLMs 和 Milvus 中实施生成性反馈循环带来了几个挑战:

- 计算需求:LLMs 需要大量的计算资源,这可能成本高昂且管理复杂。

- 数据隐私:确保这些系统内数据的保密性和完整性至关重要,尤其是在处理敏感信息时。

为应对这些挑战,考虑以下解决方案和最佳实践:

- 优化资源使用:利用具有可扩展基础设施的云服务高效处理计算负载。

- 数据匿名化:实施强大的数据匿名化技术以保护用户隐私。

- 定期审计:频繁进行安全和隐私审计,以识别和减轻潜在漏洞。

- 最佳实践:为简化流程并维护系统完整性,应用机器学习操作(MLOps)的最佳实践。

AI 生成性反馈循环的未来 随着生成性反馈循环的进步及其与大型语言模型(LLMs)和像 Milvus 这样的

向量数据库的整合,AI 的未来有望实现增长。以下是可以预期的:

- 反馈循环方法:增强的反馈循环将使 AI 能够更动态地学习和适应,促进实时应用的持续改进。

- 向量数据库:向量数据库的创新,特别是 Milvus,将促进复杂数据的有效处理,增强 AI 执行相似性搜索和基于内容的检索的能力。

- LLM 架构:LLM 架构的改进将导致对语言的更细微理解和生成,为 AI 交互和创造力开辟新途径。

关键点:

- 生成性反馈循环将显著增强 AI 的学习能力。

- 像 Milvus 这样的向量数据库将为可扩展、精确的 AI 应用提供支持。

- LLM 的进步将推动 AI 朝着更复杂、上下文感知的操作发展。

实验这些技术至关重要。通过利用生成性反馈循环、Milvus 和改进的 LLMs,开发人员和研究人员可以解锁 AI 驱动应用的新潜力,从个性化数字助手到先进的数据分析工具。这些技术的协同作用将优化现有应用,并为以前无法想象的创新解决方案铺平道路。

如果您对探索 Milvus 和大型语言模型(LLMs)的能力感兴趣,Zilliz 提供了丰富的资源和社区论坛。以下是如何参与的方式:

- 探索资源:Zilliz 提供各种白皮书、网络研讨会和培训,帮助您了解向量搜索和 AI 技术。

- 加入社区:在 Zilliz Cloud Developer Hub 上与不断增长的开发人员和用户社区互动。

- 尝试 Milvus:开始使用 Milvus 构建,并在其 AI 应用中体验其强大的功能。注册免费账户并尝试可用的 SDK。

无论您是开发人员还是刚开始,这些资源和论坛是连接、学习和为 Milvus 和 LLMs 的 AI 未来做出贡献的好方法。

技术干货

向量数据库发展迎里程碑时刻!Zilliz Cloud 全新升级:超高性价比,向量数据库唾手可得

升级后的 Zilliz Cloud 不仅新增了诸如支持 JSON 数据类型、动态 Schema 、Partition key 等新特性,而且在价格上给出了史无前例的优惠,例如推出人人可免费使用的 Serverless cluster 版本、上线经济型 CU 等。这意味着,更多的开发者可以在不考虑预算限制的情况下畅用云原生向量数据库。

2023-6-15

技术干货

打磨 8 个月、功能全面升级,Milvus 2.3.0 文字发布会现在开始!

七大变化详解 Milvus 2.3.0

2023-9-1

技术干货

GPTCache 悬赏令!寻找最佳捉虫猎手,豪华赏格等你来拿!

捉虫数量越多,奖品越丰厚!

2023-8-2