走向生产:LLM应用评估与可观测性

随着许多机器学习团队准备将大型语言模型(LLMs)投入生产,他们面临着重大挑战,例如解决幻觉问题并确保负责任的部署。在解决这些问题之前,有效评估和识别它们至关重要。

最近,在非结构化数据聚会上,Arize AI的机器学习解决方案架构师Hakan Tekgul分享了进行快速准确LLM评估的有见地的策略。这些方法保持了高答案质量和可靠性标准,并确保了实际业务价值的交付。

**观看Hakan Tekgul演讲的回放**

如果你错过了活动,别担心!这里是Hakan演讲的详细分解。

将GenAI演示过渡到生产是具有挑战性的!

最初,构建GenAI应用程序可能看起来很简单,特别是像LangChain和LlamaIndex这样的用户友好的工具,它们促进了演示应用程序的创建。然而,过渡到能够驱动实际业务价值的成熟产品是具有挑战性的。关键在于保证这些应用程序在生产环境中始终如一地提供可靠、高质量的输出。

从Twitter演示过渡到现实世界产品的体验如何?

让我们以一个电子商务聊天机器人示例来说明这一挑战。用户与这个聊天机器人互动来计划他们的假期。

电子商务聊天机器人的界面

虽然从用户的角度来看应用程序可能看起来很简单,但幕后的工作流程却很复杂。以下是此工作流程的关键步骤:

- **聊天启动**:用户通过与聊天机器人互动来启动会话。

- **参数提取**:LLM从用户输入中提取结构化参数。

- **排名/推荐**:模型根据提取的参数生成潜在假期目的地列表。

- **嵌入搜索和检索**:系统通过执行向量搜索来细化列表,以获取更相关信息。

- **响应生成**:LLM根据检索到的数据生成个性化响应。

聊天机器人工作流程的关键步骤及潜在故障排除策略

此工作流程的每个步骤都可能遇到特定问题。有效的故障排除对确保无缝的用户体验和最佳性能至关重要。例如,您可能需要:

- 确保LangChain和LlamaIndex等工具的顺利运行,无错误。

- 制作并完善提示,以准确从用户输入中提取数据。

- 持续评估并优化推荐系统。

- 提高检索信息的准确性和相关性。

- 对整个系统和每个组件单独进行故障排除。

- 利用反馈不断细化和增强系统。

LLM可观测性来拯救!

为了应对前面概述的挑战,利用评估工具实现无缝的LLM可观测性至关重要。LLM可观测性的五个主要方面需要关注,以确保对您的应用程序有完全的可见性。通过熟练地进行这些评估,团队可以实现对应用程序的全面观察,确保可靠性和最佳性能。

**LLM可观测性的五大支柱**

| 支柱 | 描述 | 常见问题 | 评估 |

| 系统评估 | 使用单独的评估LLM系统性地评估LLM输出 | 输出质量和一致性 | |

| Spans和Traces | 详细了解工作流程故障 | 识别特定故障点 | |

| 提示工程 | 迭代完善提示模板以改进结果 | 提高响应准确性和相关性 | |

| 搜索和检索 | 定位和改进检索上下文 | 提高检索准确性 | |

| 微调 | 针对特定数据重新训练LLM以定制性能 | 与业务特定需求对齐 |

在接下来的部分中,我们将更详细地探讨LLM评估和LLM Spans和Traces类别,以突出它们在优化LLM可观测性方面的重要性。

LLM评估

LLM评估(LLM Evals)指的是使用单独的LLM作为“裁判”,系统性地评估您的GenAI应用程序的输出。定期评估保证生成的内容满足质量标准并满足用户期望。例如,假期建议服务使用评估LLM定期审查建议。如果建议变得过时或不相关,这个评估系统触发审查流程以更新训练数据。

模型评估与LLM评估

在深入细节之前,让我们比较两个类似的概念:模型评估和LLM评估。

模型评估帮助您选择应用程序的基础模型,并确保它与一般用例保持一致。

LLM评估衡量您基于LLM的应用程序中特定任务和组件的性能。LLM评估包括检索、幻觉、用户挫败感、问答、摘要和代码生成评估,如下所示。

生产LLM评估 - 任务性能测量 | Arize

LLM评估如何工作

使用法官LLM评估大型语言模型(LLM)的性能可能看起来很复杂,但有了正确的工具和方法,它就变得容易管理得多。Phoenix LLM评估库是一个开源工具,旨在促进快速简单的LLM评估。该库将法官LLM、评估模板和模型参数整合到一个协调的框架中。

这个过程是如何工作的?您的输入数据与您的LLM应用程序生成的输出数据一起输入到Phoenix库中。库中的法官LLM然后使用这些输入和输出数据,以及提示模板,来评估您的系统在特定任务上的性能。

LLM评估 - 它们通常如何工作

让我们看看评估过程。考虑一个检索增强生成(RAG)应用程序,它从像Milvus这样的向量数据库中检索上下文,然后根据用户的问题和检索到的上下文生成响应。

在衡量RAG检索任务的性能时,输入数据(用户的问题)和输出数据(参考文本)被输入到Phoenix库中。法官LLM使用评估模板来评估参考文本回答用户问题的程度。例如,如果用户的问题是“寻找传统的法国食谱”,参考文本提供了焦糖洋葱面包汤食谱,评估模板将比较这两者以评估它们的相关性。

LLM评估 - RAG用例中的工作方式

对您的LLM评估结果进行基准测试

我们已经讨论了LLM评估过程的工作原理,但你如何确定它对您的特定用例有效?答案在于对评估结果进行基准测试。

以下是我们进行基准测试的主要步骤。

首先,我们使用包含人工标记答案的公共数据集。这些数据集包括用户问题和参考文本,以及指示其相关性的注释。有了这些建立良好的数据集,我们为比较建立了坚实的基础。

接下来,我们将我们的提示模板的性能与这些公共数据集中人工提供的答案进行比较。这一步使我们能够评估我们的模板使用人工判断作为基准识别相关响应的能力。

最后,我们计算精确度和召回率分数,以量化我们的提示模板的性能。精确度衡量RAG系统返回的相关结果的准确性,而召回率衡量系统检索所有相关实例的能力。

这些精确度和召回率分数表明我们的提示模板在广泛的人工标记示例中的表现如何有效。这个基准测试过程确保评估和提示模板是可靠的,可以信任它们来评估您的LLM应用程序的性能。

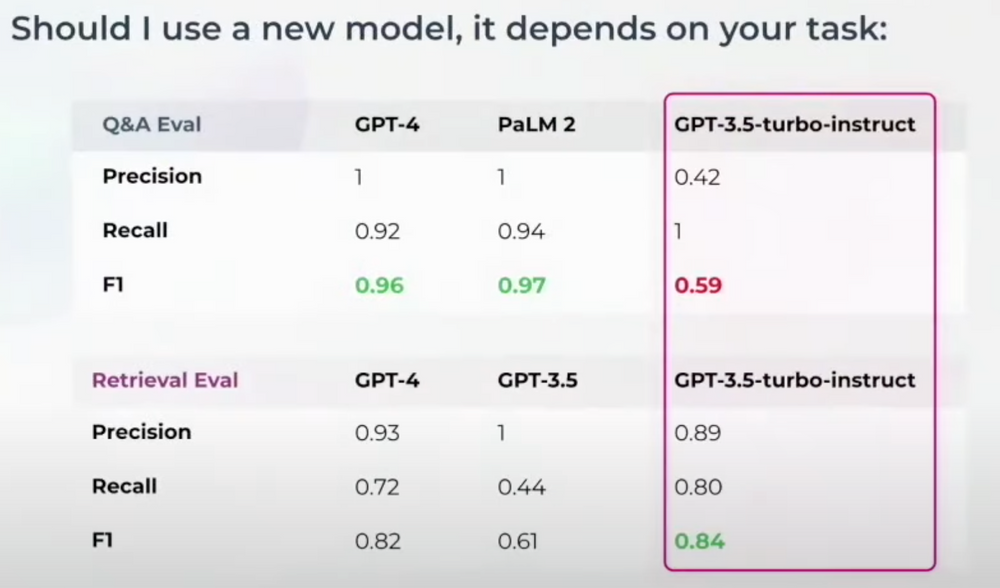

在这些测量之后,确定要为您的法官LLM使用哪个模型。不同的任务可能需要不同的法官模型。例如,GPT-3.5-turbo-instruct在问答正确性评估上可能表现不佳,但在检索评估上做得很好。如果您正在评估其他内容,您可能需要切换基础模型。这就是为什么基准测试至关重要。

在这些测量之后,下一步是确定要为您的法官LLM使用哪个模型。不同的任务可能需要不同的法官模型。例如,GPT-3.5-turbo-instruct在问答正确性评估上可能表现不佳,但在检索评估上表现出色。您可能需要切换基础模型以评估不同的方面。这种灵活性是基准测试至关重要的原因。

LLM Spans和Traces

现在我们已经学会了如何整体评估您的LLM应用程序。但是您如何逐个组件评估您的应用程序交互呢?考虑建立在像LamaIndex或LangChain这样的框架上的完整检索系统链。如果问答评估指示错误答案,您只知道交互失败,但您仍然需要确定在哪里失败。这就是LLM Spans和Traces的概念所在。

各种类型的Span评估可以帮助确定失败的位置。例如,您可以使用:

- 用户挫败感评估来检查聊天机器人交互

- 在属性提取期间进行分类评估

- 检索评估以评估检索组件

- 分类过程中的分类评估

LLM Spans评估

如果在检索评估中存在问题,它直接影响问答正确性。LLM Spans和Traces有助于在您的应用程序内可视化和诊断这些问题。

Hakan还分享了一个演示,展示了LLM Spans和Traces的工作原理。在YouTube上观看他的演讲回放,以查看更多演示细节。

**结论**

反思Hakan Tekgul的演讲,很明显,将LLM投入生产并非易事。从精心制作的演示到可靠、业务就绪的应用程序的旅程充满了挑战,这些挑战需要关注细节和强大的可观测性框架。

Hakan分享了两种主要的LLM评估策略,LLM评估和LLM Spans和Traces,并解释了它们如何通过详细的例子协同工作。这些策略系统地评估LLM应用程序,确保它们在现实世界用例中的可靠性和有效性。

技术干货

如何在 Jupyter Notebook 用一行代码启动 Milvus?

本文将基于 Milvus Lite,为大家介绍如何在 Jupyter Notebook 中使用向量数据库。

2023-6-12

技术干货

打磨 8 个月、功能全面升级,Milvus 2.3.0 文字发布会现在开始!

七大变化详解 Milvus 2.3.0

2023-9-1

技术干货

向量数据库发展迎里程碑时刻!Zilliz Cloud 全新升级:超高性价比,向量数据库唾手可得

升级后的 Zilliz Cloud 不仅新增了诸如支持 JSON 数据类型、动态 Schema 、Partition key 等新特性,而且在价格上给出了史无前例的优惠,例如推出人人可免费使用的 Serverless cluster 版本、上线经济型 CU 等。这意味着,更多的开发者可以在不考虑预算限制的情况下畅用云原生向量数据库。

2023-6-15