探索 OpenAI CLIP:多模态 AI 学习的未来发展

人工智能(AI)正在戏剧性地转变,从传统方法向一种新方法——多模态 AI 学习转变。这些系统可以像人类一样从各种模态获取输入并理解信息。文本、图像和音频可以一起处理,从而对世界有更深入、更精细的理解。

在这场多模态学习革命的前沿,是 OpenAI 的 CLIP(Contrastive Language-Image Pre-training,对比语言-图像预训练),这是一个用于文本和图像数据的开创性模型。CLIP 将 AI 学习推向了新的高度,扩展了我们的理解范围,使我们能够使用“眼睛”和“舌头”。

本文将探讨 CLIP 的内部工作机制及其在多模态学习中的开创性潜力。

什么是 OpenAI CLIP?

OpenAI 在 2021 年推出了 CLIP。该模型专注于通过自然语言监督学习视觉概念。计算机视觉任务通常是有监督的,训练数据限制了模型的性能。OpenAI 团队发现,用图像的原始文本描述对模型进行预训练,使其能够开箱即用地在更广泛的视觉任务中表现出色。

CLIP 代表对比语言图像预训练。它在互联网上收集的 4 亿个文本-图像对上进行了预训练。该模型使用独立的线性分类器对图像嵌入进行字幕处理。CLIP 通过训练文本和图像编码器同时对比两种模态,将图像和文本数据映射到共享空间。这种方法标志着我们今天看到的复杂多模态系统的开创性发展,例如 LlAVA、GPT-4 视觉等。

在文本-图像对上的广泛预训练以及将文本和图像模态整合到单一模型中,使 CLIP 能够识别未见过的标签。它可以在以前从未见过的图像和文本之间建立联系。这使得 CLIP 在多样化的场景中展现出惊人的性能。

对比预训练

零样本学习与 CLIP

零样本学习意味着 CLIP 能够在没有针对特定示例进行训练的情况下识别新对象并生成新的联系。流行的图像生成模型,如 DALL-E 和 Stable Diffusion,在它们的架构中使用 CLIP 进行图像理解编码。

图像生成模型架构

旧的 SOTA 图像分类模型的能力仅限于它们训练过的数据集;例如,ImageNet 模型的零样本能力仅限于分类它训练过的 1000 个类别。

如果有人想执行任何其他视觉任务,他们必须附加一个新的头到 ImageNet 模型,整理一个标记过的数据集,并微调模型。但是 CLIP 可以现成地用于各种视觉任务,无需任何微调或标记数据。

CLIP 足够多功能,可以处理许多视觉分类任务,无需额外的训练数据。要将 CLIP 用于不同的任务,只需通知其文本编码器与任务相关的视觉概念。因此,CLIP 会根据其视觉表示生成一个线性分类器。值得注意的是,这个分类器的精度经常与经过完全监督训练的模型相媲美。

Unsplash 使用 CLIP 来标记他们的图像。我们可以看到 CLIP 在不同数据集的一些随机样本上惊人的零样本预测能力。

图像标记

有效索引 CLIP 嵌入

如果我们在具有许多目标类别或大型图像组的数据上使用 CLIP 进行零样本任务,手动执行可能会耗尽计算资源和时间。另一方面,我们可以使用向量数据库高效地索引 CLIP 嵌入。例如,考虑按类别标记 UnSplash 上的大量图像集合。我们可以将计算出的图像嵌入保存在像 Zilliz! 这样的高效且多样化的向量存储中。找到每个类别标签最相似的图像向量的 top k。

使用向量存储进行大规模零样本图像标记只是向量存储如 Zilliz 可以高效帮助我们充分利用强大的多模态模型如 CLIP 的真正潜力的几个用例之一。我们可以将这种组合的效用扩展到许多其他用例,如语义搜索、无监督数据探索等!

实现 CLIP:指南

让我们使用 HugginFace 的预训练 CLIP 模型执行零样本图像分类。HF hub 为各种预训练的 CLIP 模型变体提供了相当多的选项。我们将使用 "openai-/clip-vit-bse-patch32" 模型,并将使用 transformers 库对 MS-COCO 数据集中的一些样本进行图像分类。

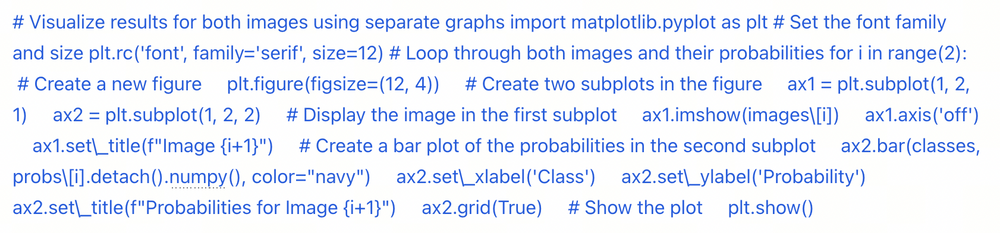

步骤 1. 使用 Hugging Face 的 Transformers 库可以加载 OpenAI CLIP ViT-Base 模型,代码如下:

47.11.png

47.11.png

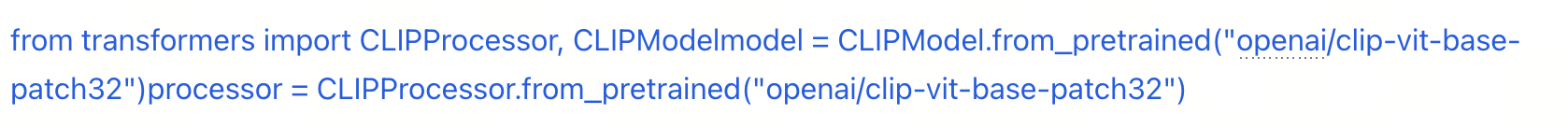

步骤 2. 现在,你可以通过运行以下代码从 COCO 数据集中检索一些图像:

47.22.png

47.22.png

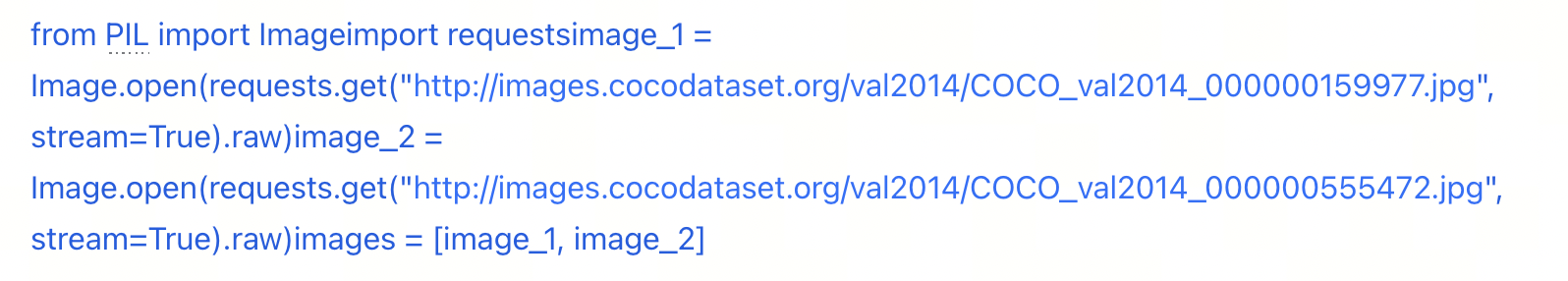

步骤 3. 要将图像可视化为输出,以下是带有视觉输出的代码片段:

47.33.png

47.33.png

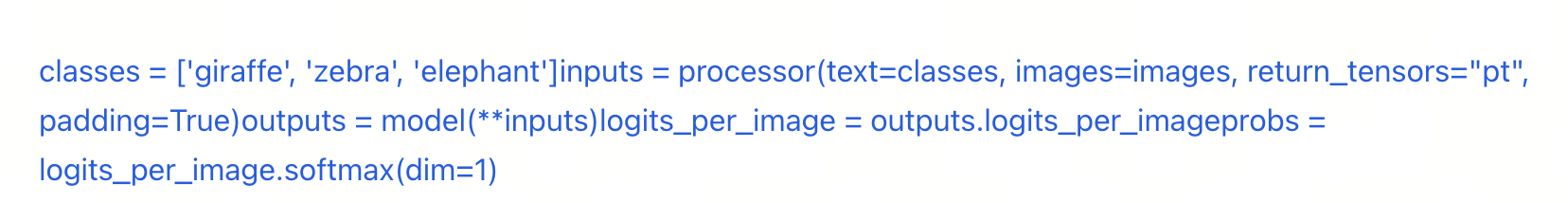

步骤 4. 在这一步,你可以使用 CLIP 进行零样本推理,运行以下简单代码即可:

47.44.png

47.44.png

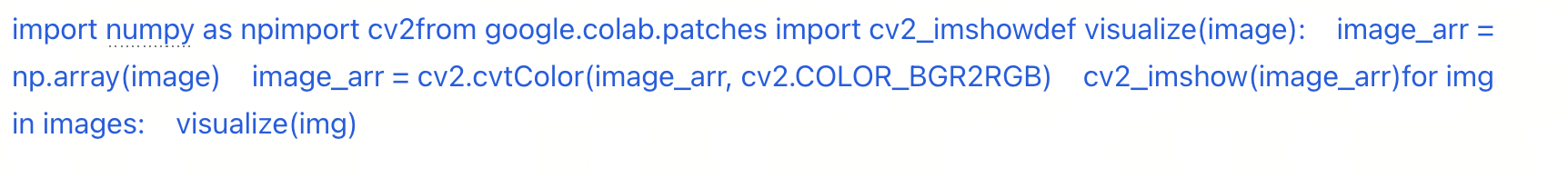

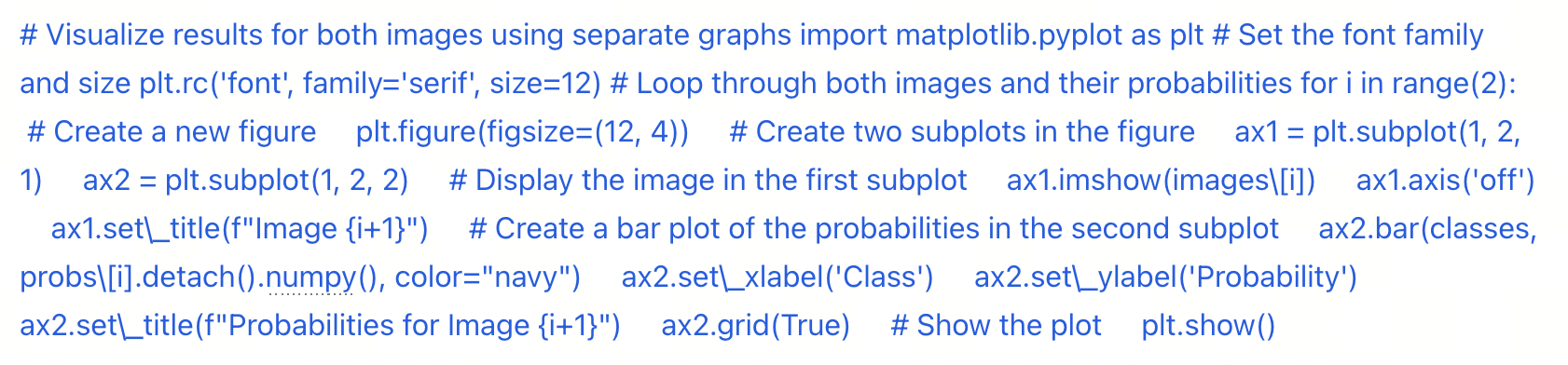

步骤 5. 最后,为了对图像进行分类,你可以简单地使用图表可视化两个图像的结果;以下代码将生成带有图表的图像输出:

47.55.png

47.55.png

结论

OpenAI 的 CLIP 转变了多模态 AI 学习的力量。通过开创零样本学习的概念并优化文本到图像的检索,CLIP 改变了机器学习和与世界互动的视角。

CLIP 在文本到图像检索期间的预训练能够实现各种图像分类场景。它也可以根据需要进行定制,不仅限于一个任务。这些特性使 CLIP 成为一个在多个领域中极具前景的工具,包括图像搜索、医学诊断和电子商务等。

CLIP 与其他模型的不同之处在于其令人兴奋的能力,即在没有广泛或事先学习的情况下执行新任务。这导致了 AI 中的杰出和开创性进步,为创新铺平了道路,例如我们今天所见证的图像生成模型(稳定扩散系列).

技术干货

LangChain 查询使用指「北」

LangChain 是一种 AI 代理工具,可以为以 ChatGPT 为代表的额大语言模型(LLM)增添更多功能。此外,LangChain 还具备 token 和上下文管理功能。本文主要通过查询 GPT 和查询文档两个示例介绍如何使用 LangChain。

2023-5-30

技术干货

向量数据库发展迎里程碑时刻!Zilliz Cloud 全新升级:超高性价比,向量数据库唾手可得

升级后的 Zilliz Cloud 不仅新增了诸如支持 JSON 数据类型、动态 Schema 、Partition key 等新特性,而且在价格上给出了史无前例的优惠,例如推出人人可免费使用的 Serverless cluster 版本、上线经济型 CU 等。这意味着,更多的开发者可以在不考虑预算限制的情况下畅用云原生向量数据库。

2023-6-15

技术干货

一次解决三大成本问题,升级后的 Zilliz Cloud 如何造福 AIGC 开发者?

对于应用开发而言,成本问题向来是企业和开发者关注的重点,更迭迅速、变化莫测的 AIGC 时代更是如此。这里的成本既指软件开发成本,也包括硬件成本、维护成本。Zilliz Cloud 可以一次性解决这三大问题,帮助开发者降低开发成本、优化硬件成本、减少维护成本。

2023-7-6