Langflow + Milvus,拖拉拽就能搞定的workflow教程来了

小白也能上手的AI workflow教程

如果你想写个agent或者workflow,但是又不想在demo阶段投入太多精力去敲代码;

或者作为公司的运营或者销售,虽然代码能力平平,也想做个自己的workflow。

那么不妨试试低代码可视化平台,通过简单的拖放式 UI 连接生成式 AI 模型的组件,无需编写专业脚本就能构建和修改复杂的AI workflow,并且一键部署集成。

本文将以Langflow+Milvus 为例,带来完整演示。

01

选型思路

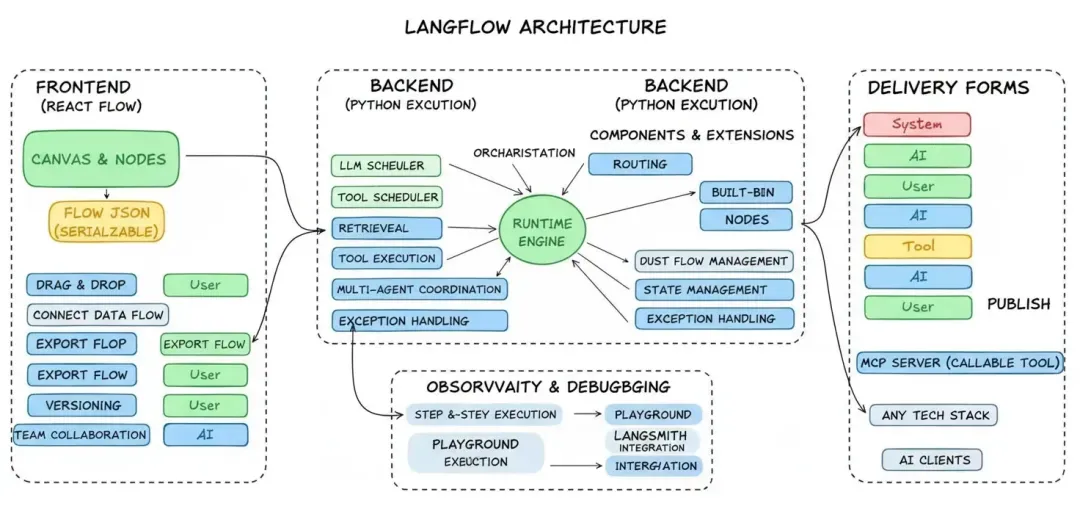

LangFlow架构的核心思想是:让画布成为可执行的文档,既是成品也是沟通平台。

过去,搭建一个产品,需要产品经理提需求,架构师设计方案,工程师写代码,串行进行。Langflow 不仅做到了拖拉拽低代码运行,还能让协作变成并行的,通过可视化开发方式,我们甚至可以将试错周期从数周缩短至数小时。

06-01-1.webp

06-01-1.webp

其看得见的部分是画布与节点。前端基于 React Flow 构建,用户拖拽节点、连接数据流,就像搭乐高一样直观。后端则是实时生成 Flow JSON(可以理解为"乐高搭建图纸"),支持导出、版本管理和团队协作。

在这背后,Python 驱动的运行时引擎负责调度 LLM、工具、检索、路由等组件,处理数据流转、状态管理与异常。

此外,LangFlow还有组件库与自定义能力:内置主流 LLM、向量库的适配器,也支持用 Python 写自定义节点。并提供逐步执行、Playground 快速试验,与 LangSmith、LangFuse 等平台集成,方便回放执行链路、追踪性能。

在这个整体架构基础上,我们选择引入Milvus作为我们的向量数据库,存储企业内部的私有数据或者行业知识。

02

五分钟demo演示

演示目标:

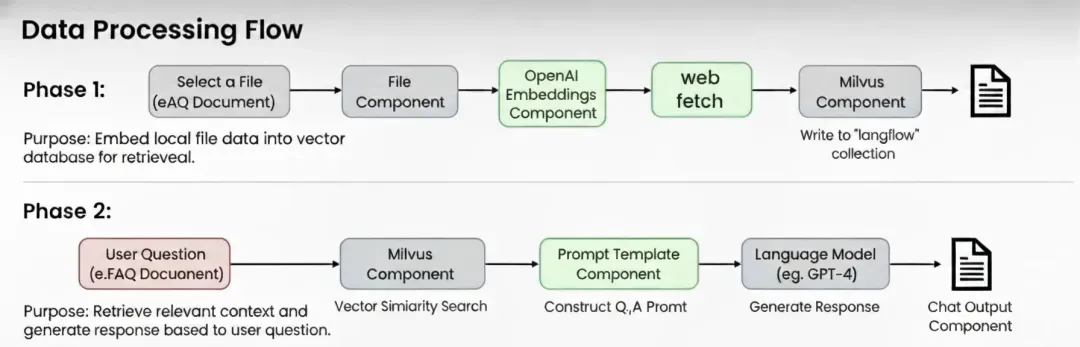

使用Langflow官方RAG模板,演示如何用Milvus将本地数据构建向量索引并实现高效上下文增强问答。

06-01-2.webp

06-01-2.webp

环境准备:

- python3.11或conda

- uv

- docker & docker-compose

- Openai-key

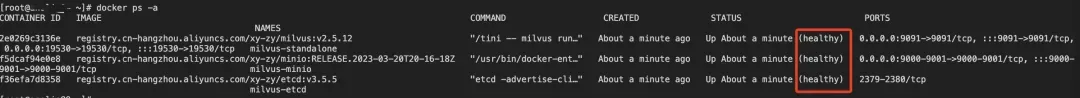

1. 部署Milvus向量数据库

下载部署文件

wget https://github.com/Milvus-io/Milvus/releases/download/v2.5.12/Milvus-standalone-docker-compose.yml -O docker-compose.yml

启动Milvus服务

docker-compose up -d

docker-compose ps -a

06-01-3.webp

06-01-3.webp

2. 创建python虚拟环境

conda create -n langflow

# 激活langflow并进入

conda activate langflow

3. 安装最新的包

pip install langflow -U

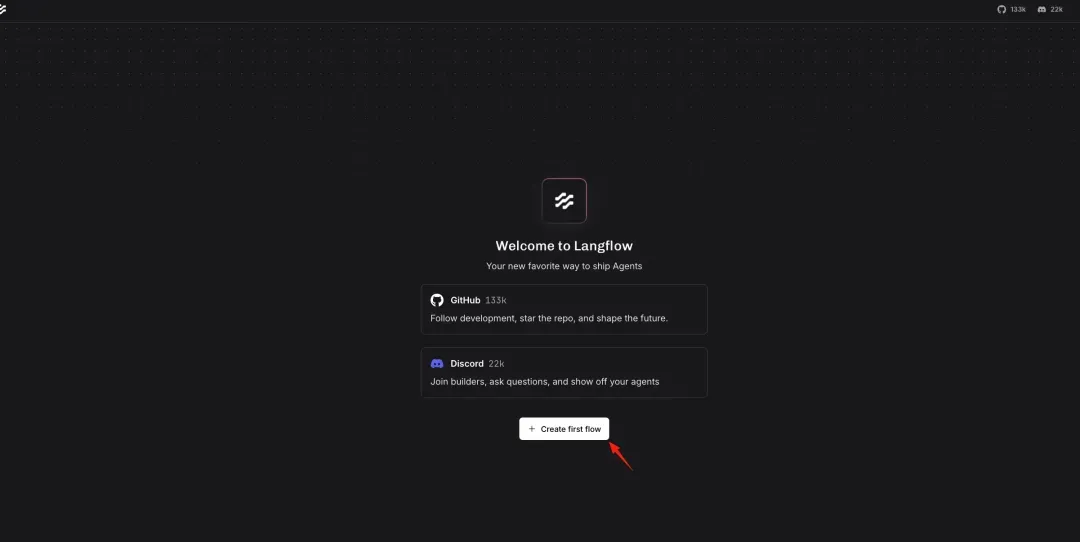

4. 启动langflow

uv run langflow run

访问langflow http://127.0.0.1:7860

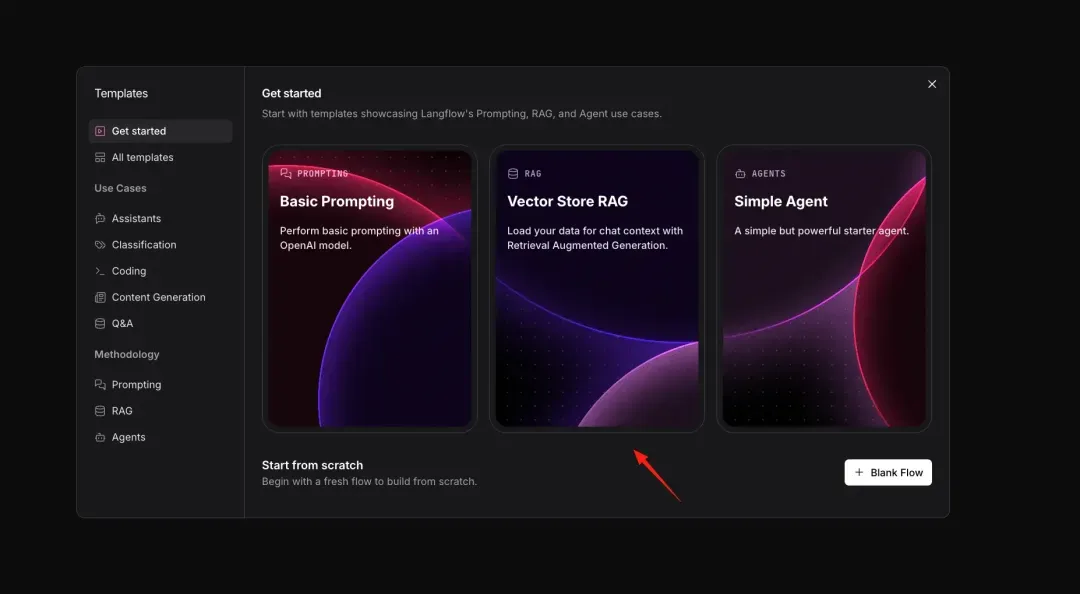

5. 搭建配置RAG场景

选择官方RAG模板

06-01-4.webp

06-01-4.webp

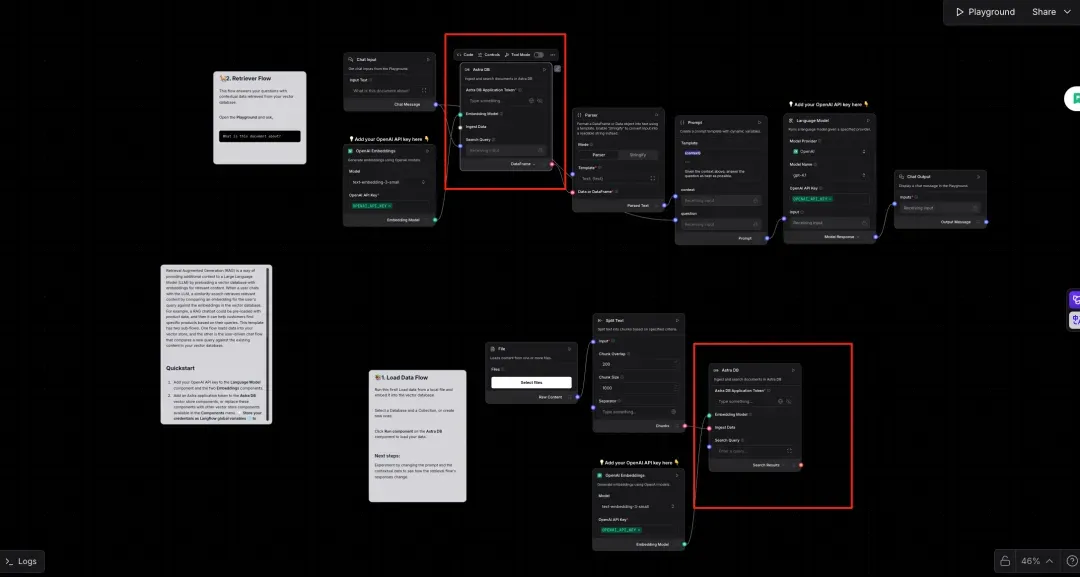

06-01-5.webp

06-01-5.webp

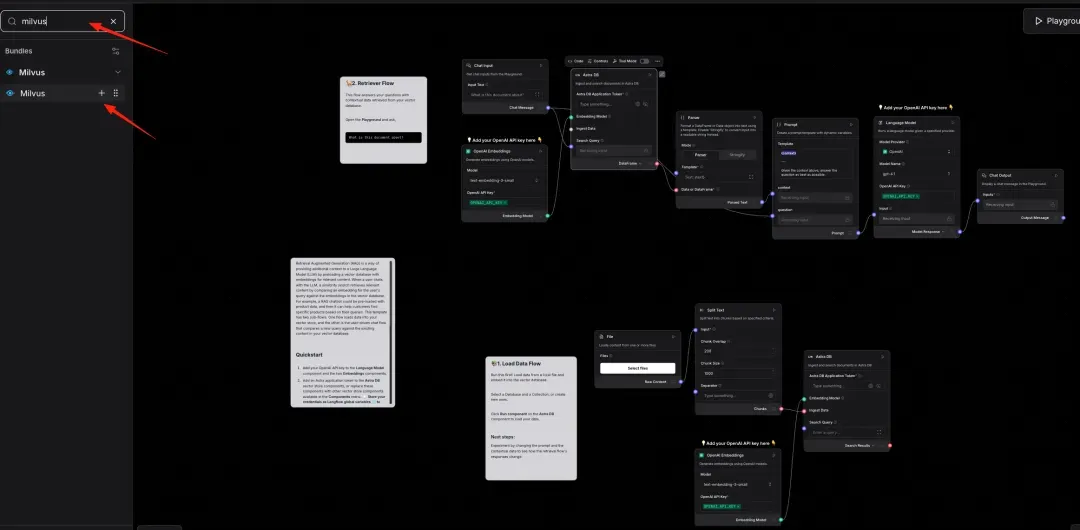

替换向量数据库

说明:将默认的VDB换成Milvus

06-01-6.webp

06-01-6.webp

左侧输入Milvus并添加

06-01-7.webp

06-01-7.webp

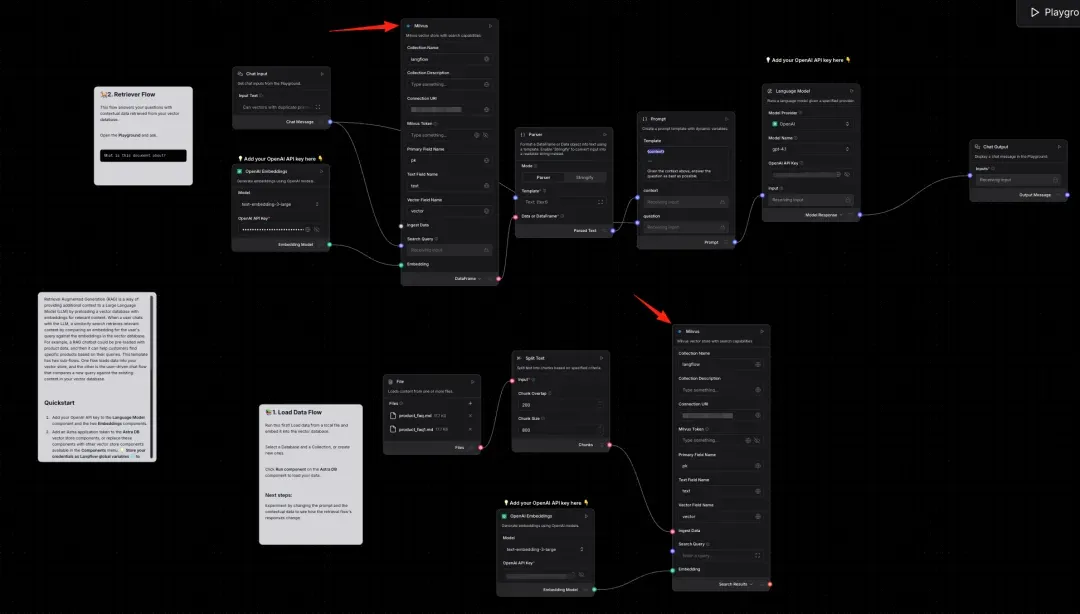

06-01-8.webp

06-01-8.webp

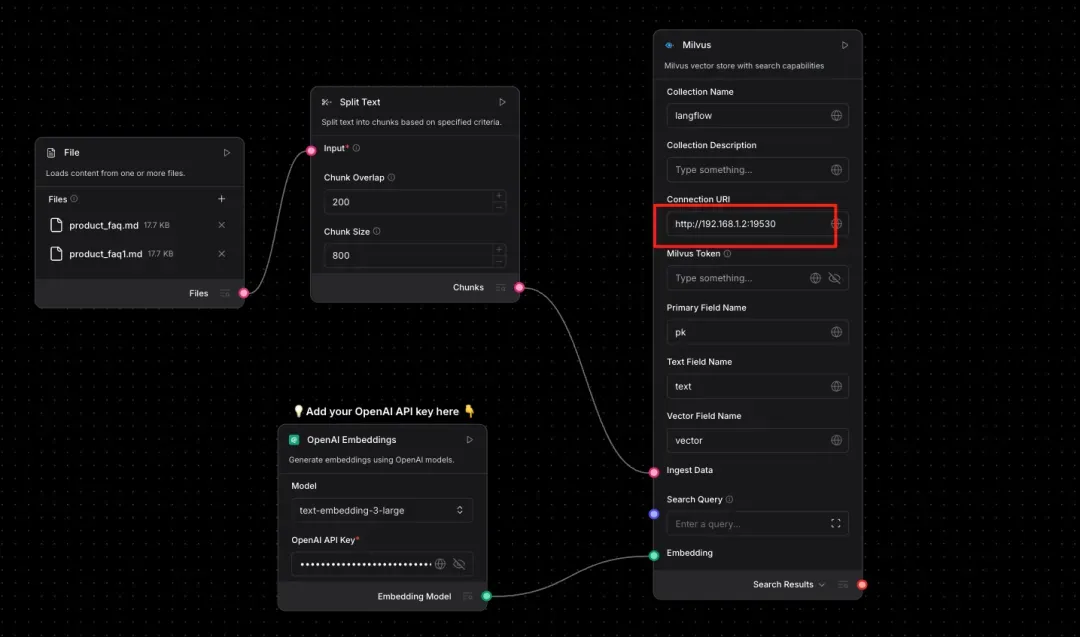

配置Milvus连接信息

说明:只需填写Milvus连接信息即可,其他选项暂时默认。

06-01-9.webp

06-01-9.webp

06-01-10.webp

06-01-10.webp

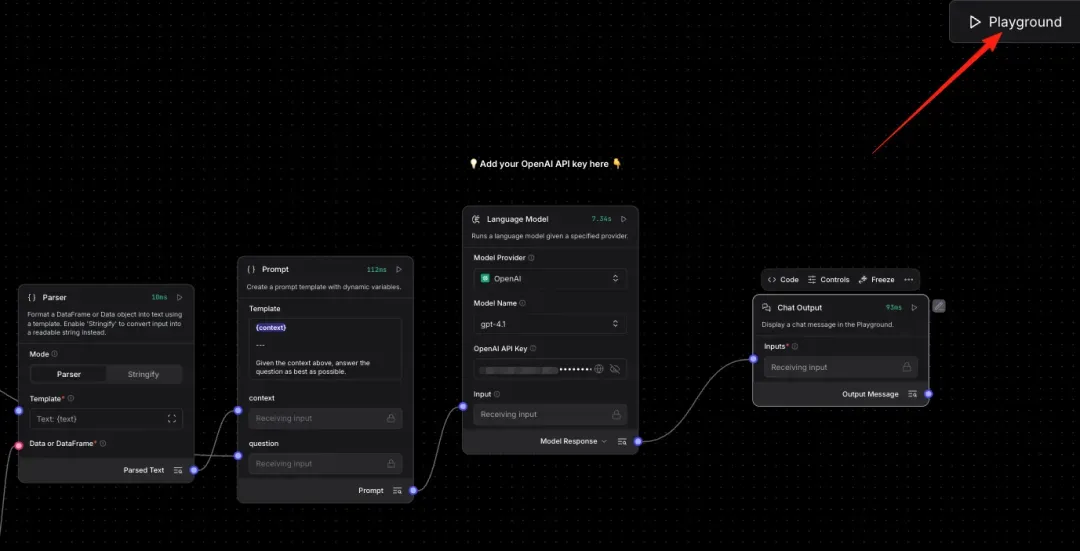

配置OpenAi的key

06-01-11.webp

06-01-11.webp

640 (2).webp

640 (2).webp

6. 测试数据准备

说明:使用Milvus2.6版本官方FAQ

https://github.com/milvus-io/milvus-docs/blob/v2.6.x/site/en/faq/product_faq.md

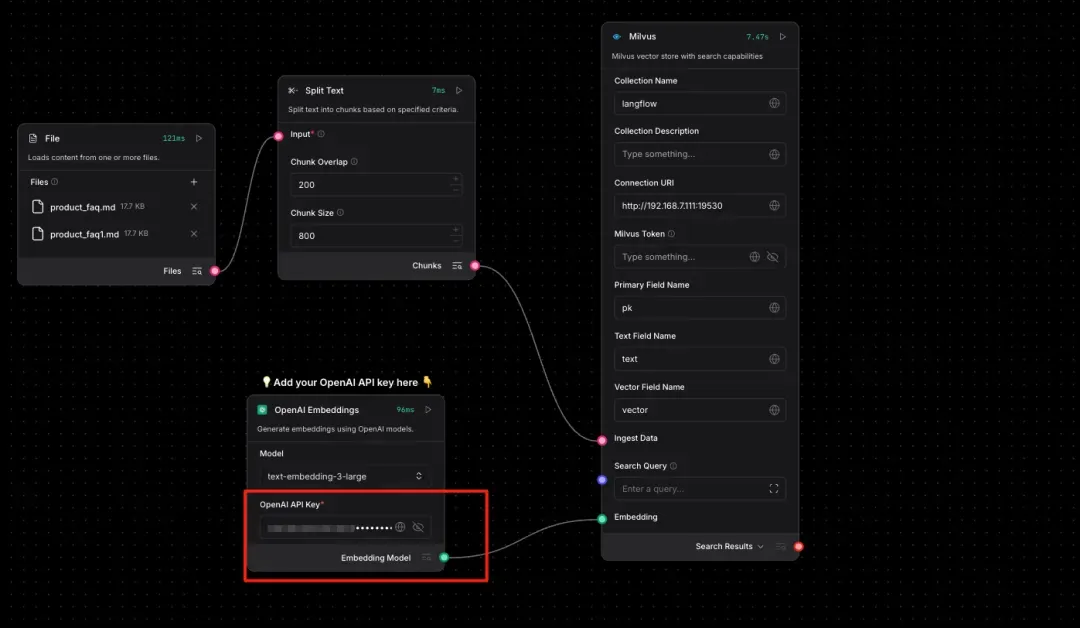

7. 第一阶段测试

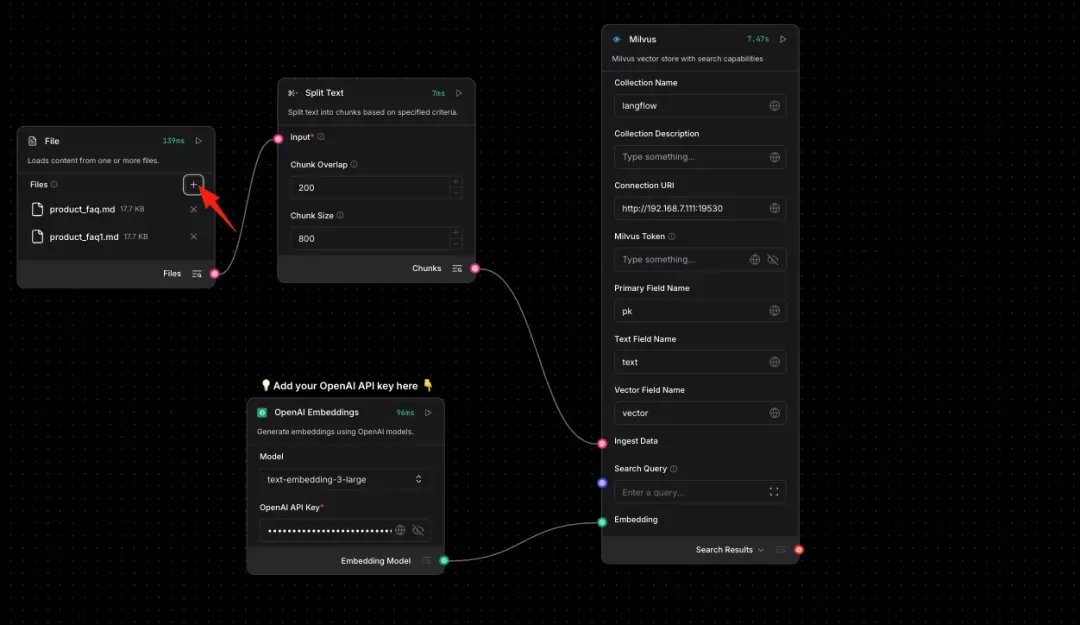

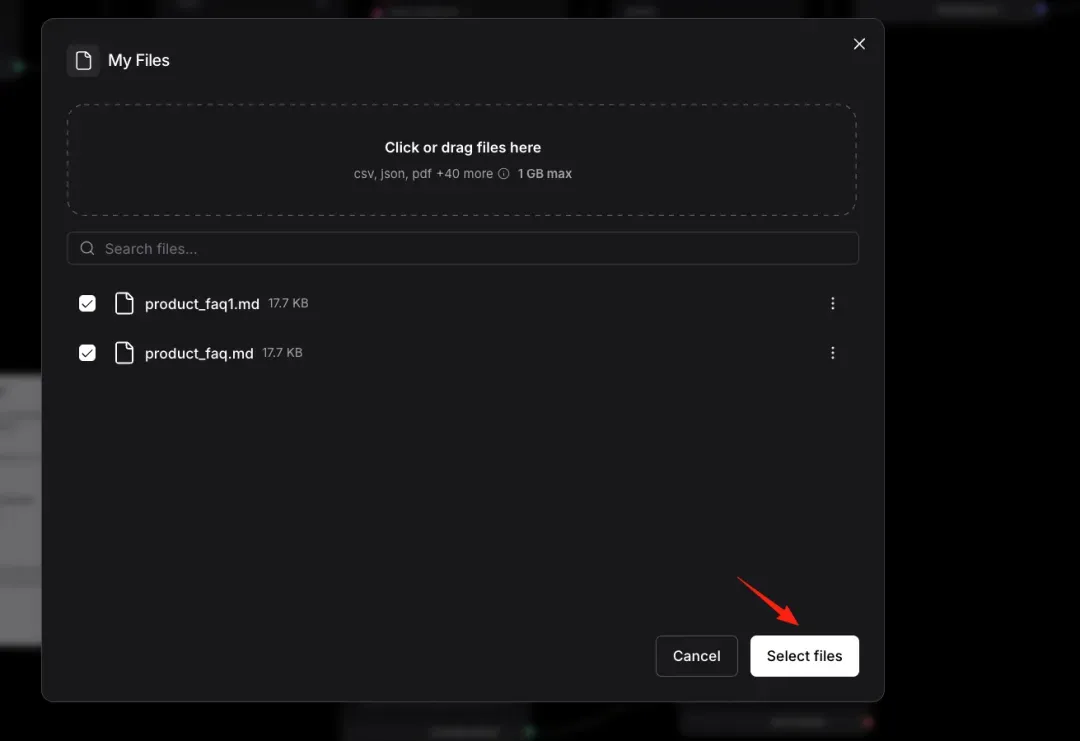

上传数据库并嵌入Milvus

说明:必须上传2份以上的数据集才能正常嵌入Milvus,这是Langflow官方节点的Bug还未修复。

06-01-13.webp

06-01-13.webp

06-01-14.webp

06-01-14.webp

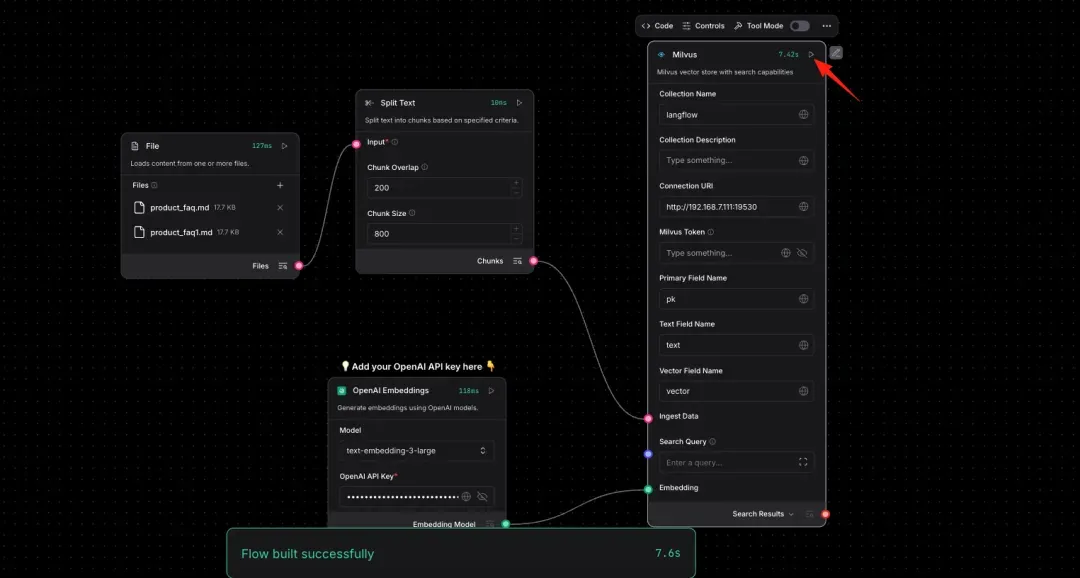

测试节点状态

06-01-15.webp

06-01-15.webp

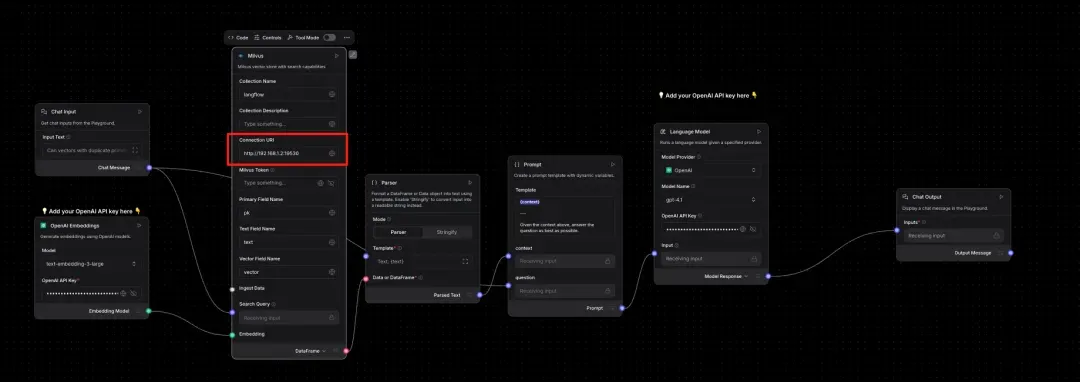

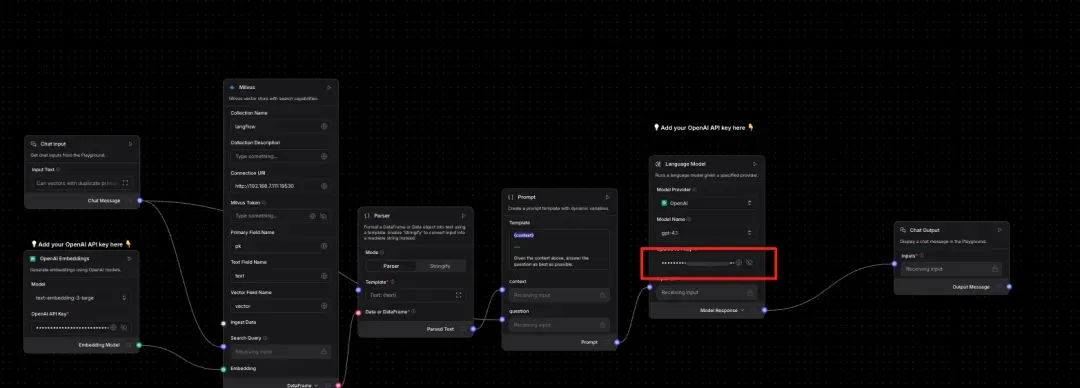

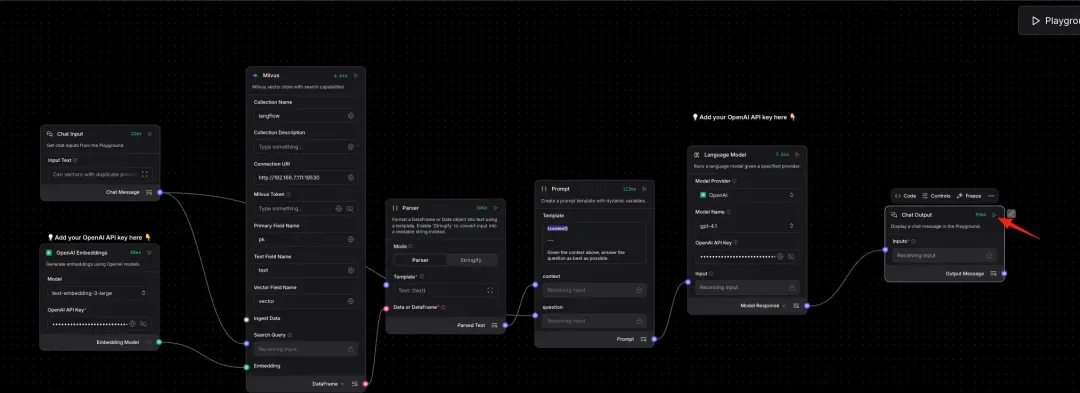

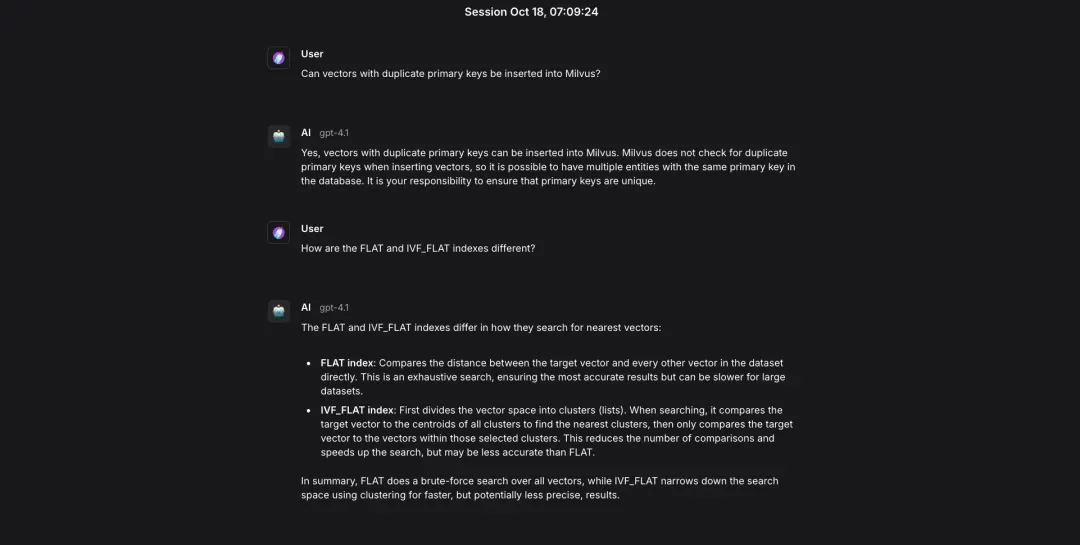

8. 第二阶段测试

06-01-16.webp

06-01-16.webp

9. 综合测试

640 (3).webp

640 (3).webp

640 (4).webp

640 (4).webp

03

写在最后

整体来说,Langflow低门槛、可视化,上手快,但Langflow并非万能。它更适合快速原型开发、业务逻辑频繁变更的项目、需要跨团队协作的应用、教学和演示场景。

而对性能有极致要求的系统、需要深度定制的底层逻辑、已有大量LangChain代码的成熟项目,可能不是那么适合。

技术干货

向量数据库发展迎里程碑时刻!Zilliz Cloud 全新升级:超高性价比,向量数据库唾手可得

升级后的 Zilliz Cloud 不仅新增了诸如支持 JSON 数据类型、动态 Schema 、Partition key 等新特性,而且在价格上给出了史无前例的优惠,例如推出人人可免费使用的 Serverless cluster 版本、上线经济型 CU 等。这意味着,更多的开发者可以在不考虑预算限制的情况下畅用云原生向量数据库。

2023-6-15

技术干货

可处理十亿级向量数据!Zilliz Cloud GA 版本正式发布

本次 Zilliz Cloud 大版本更新提升了 Zilliz Cloud 向量数据库的可用性、安全性和性能,并推出了一系列新功能。这次升级后,Zilliz Cloud 能够更好地为用户提供面向各种应用场景的向量数据库服务,不断提升用户体验。

2023-4-7

技术干货

重磅版本发布|三大关键特性带你认识 Milvus 2.2.9 :JSON、PartitionKey、Dynamic Schema

随着 LLM 的持续火爆,众多应用开发者将目光投向了向量数据库领域,而作为开源向量数据库的领先者,Milvus 也充分吸收了大量来自社区、用户、AI 从业者的建议,把重心投入到了开发者使用体验上,以简化开发者的使用门槛。

2023-6-5