服务器繁忙?10分钟本地部署DeepSeek+Milvus,增强版不排队!

过去一个月的DeepSeek有多火?

Sensor Tower数据显示,在其APP在最新的R1模型发布后,DeepSeek的前 18 天内下载量达到 1600 万次,几乎达到ChatGPT同一数据的两倍,不仅如此,DeepSeek还在全球140个国家的APP榜单中名列下载量排名第一。

刚刚收工的国内打工人,更是摩拳擦掌,期待着DeepSeek在新的一年成为自己新的AI牛马。

1.24-1.png

1.24-1.png

然而,暴涨的流量+层出不穷的DDOS攻击=服务中断宕机。

作为资深社畜兼DeepSeek的骨灰级粉丝,相信不少人最近一定感受到了类似的崩溃:

闹钟八点一响,牛马闪亮登场。开工第一天,当你满脸虔诚的将一个问题反复向DeepSeek问了不止十遍,但奈何,但DeepSeek的回复,始终是 “服务器繁忙,请稍后再试”。

1.24-2.png

1.24-2.png

那么,有什么办法,能够让你随时随地都能流畅、稳定使用“不会冷暴力”的DeepSeek,甚至是增强版DeepSeek?

答案是,本地部署。通过本地部署,我们不仅能有效缓解DeepSeek官方服务器的压力,避免了官服频繁宕机,更保证了自己的个人隐私数据,不会被上传到大模型,出现隐私泄露风险;

而对很多对于数据安全、使用频次有需求的企业或者个人来说,频繁的访问官方API,不仅效率低下,而且成本也不容小觑,本地部署同样可以解决他们关于使用体验、数据隐私以及访问成本的顾虑。

接下来,教你不花一分钱,十分钟完成一套DeepSeek+Milvus的本地部署,不仅快速享受丝滑版DeepSeek,即使小白也能快速上手。

01

选型思路

本地部署DeepSeek其实不难,很多人会采用地部署的DeepSeek通过Ollama对接VSCode这个思路。

但采用这个思路的时候,你是否也遇到过这样的困扰,通过这套方案,明明问了很具体的问题,DeepSeek却总是忽略问题,答非所问,和官方API的表现大相径庭。

1.24-3.png

1.24-3.png

为什么会这样?

原因在于Ollama默认支持的模型ctx参数并不能满足roo-code插件较长的提示。必须需要通过增加Ollama模型的上下文长度来满足。

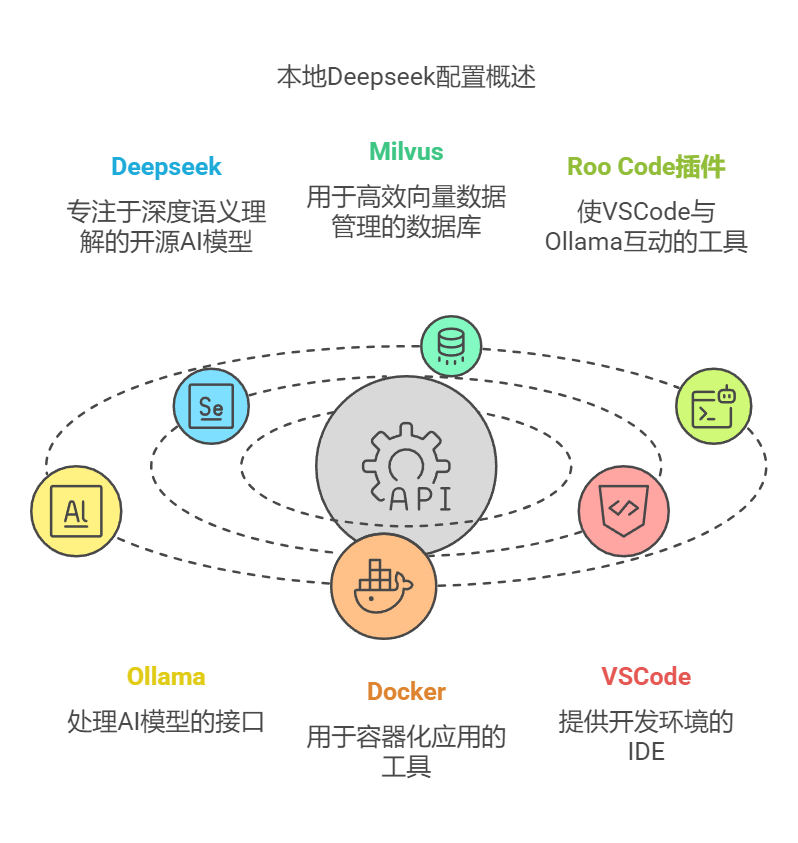

因此,我们可以引入Milvus向量数据库,以及Roo Code 插件来解决这个问题。其中,Milvus主要解决大规模向量数据的存储与高效检索,通过其强大的向量索引和查询能力,能够快速处理复杂的上下文信息,确保模型在长上下文场景下依然能够准确理解问题;而Roo Code 则主要针对代码生成和上下文关联优化,通过智能提示和上下文感知,进一步提升模型在编程场景中的表现,确保回答的准确性和相关性。

通过结合Milvus和Roo Code,不仅能有效解决Ollama默认模型在长上下文场景下的不足,让本地部署的DeepSeek表现更加接近官方API的效果,更重要的是,借助Milvus强大的向量检索能力,我们可以轻松构建起智能文档检索、相似图像搜索、智能问答系统等丰富的AI应用场景。既能准确理解用户意图,又能快速从海量数据中找到最相关的信息,真正让本地部署的AI应用既智能又高效。

(需要注意的是:不是每一个本地环境部署的DeepSeek模型在修改ctx参数后都能有同样的效果。请根据不同的模型结合显卡配置合理调整参数值。本文参数只作为参考演示。)

接下来是各个部件的具体选型思路与部署实操。

02

核心组件介绍

DeepSeek 简介

DeepSeek 是开源 AI 模型,专注于深度语义理解和自然语言处理。

它基于大规模预训练语言模型,能够准确理解文本的语义内容,支持多语言处理。其核心优势包括:语义相似度计算、文本分类、问答系统等功能。作为搜索引擎的核心组件,它可以将用户的自然语言查询转化为精确的语义表示,从而实现更智能的检索。

对于开发者而言,DeepSeek 提供了简单易用的 API 接口,可以快速集成到各类应用中,特别适合构建智能搜索、推荐系统等场景。

Milvus 简介

Milvus 是一个开源的向量数据库管理系统,专为海量非结构化数据检索设计。

它采用分布式架构,支持数十亿级向量的实时检索,并提供了多种索引类型(如IVF、HNSW等)来平衡查询速度和准确性。Milvus 的核心优势包括:高性能的相似度搜索、灵活的数据管理、可扩展的分布式部署以及与主流AI框架的无缝集成。它能将复杂的向量运算转化为高效的数据库操作,大大简化了AI应用的开发流程。

对于图像识别、语义检索等场景,Milvus可以轻松处理百万级数据,同时保持毫秒级的查询响应时间,是构建AI搜索系统的理想选择。

Roo Code 插件简介

Roo Code是一个VSCode插件,它可以让你在VSCode中直接与本地部署的Ollama进行对话。主要功能包括:

支持多种开源大语言模型,如DeepSeek、CodeLlama等

内置代码搜索引擎,可以快速检索代码片段

提供代码补全、代码解释、代码重构等智能编程辅助功能

完全本地化部署,保护代码隐私和数据安全

界面简洁直观,操作便捷,适合各类开发者使用

1.24-4.png

1.24-4.png

03

实操部署

一、使用 Ollama 运行 DeepSeek

为保证资源隔离,本文将Ollama和milvus部署在不同服务器中。

1. Ollama安装要求

操作系统:Windows、Linux、macOS

内存:至少16GB

硬盘:至少100GB

显卡:NVIDIA系列 至少8GB以上

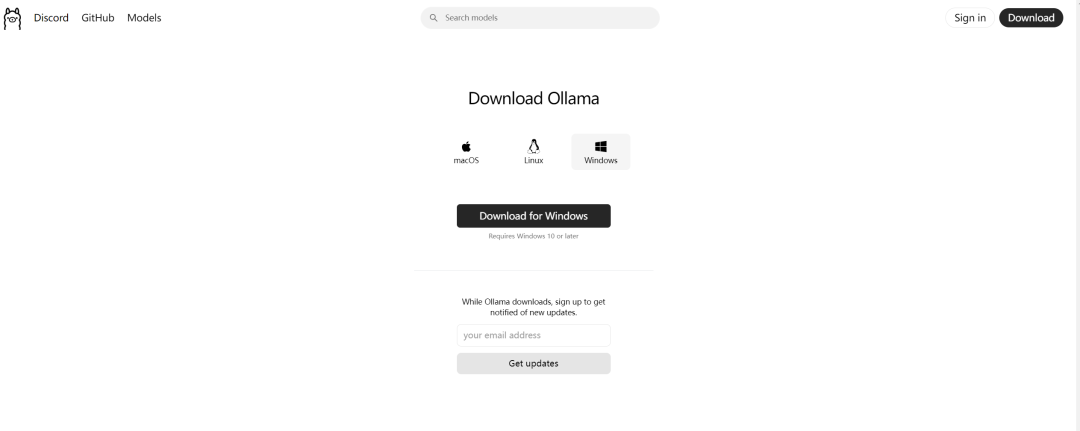

1.1 下载 Ollama

根据不同操作系统,下载对应的Ollama安装包

官网:https://Ollama.ai/

1.24-5.png

1.24-5.png

1.2 安装并启动 Ollama

[root@Ollama ~]# curl -fsSL https://ollama.com/install.sh | sh

[root@Ollama ~]# bash install.sh

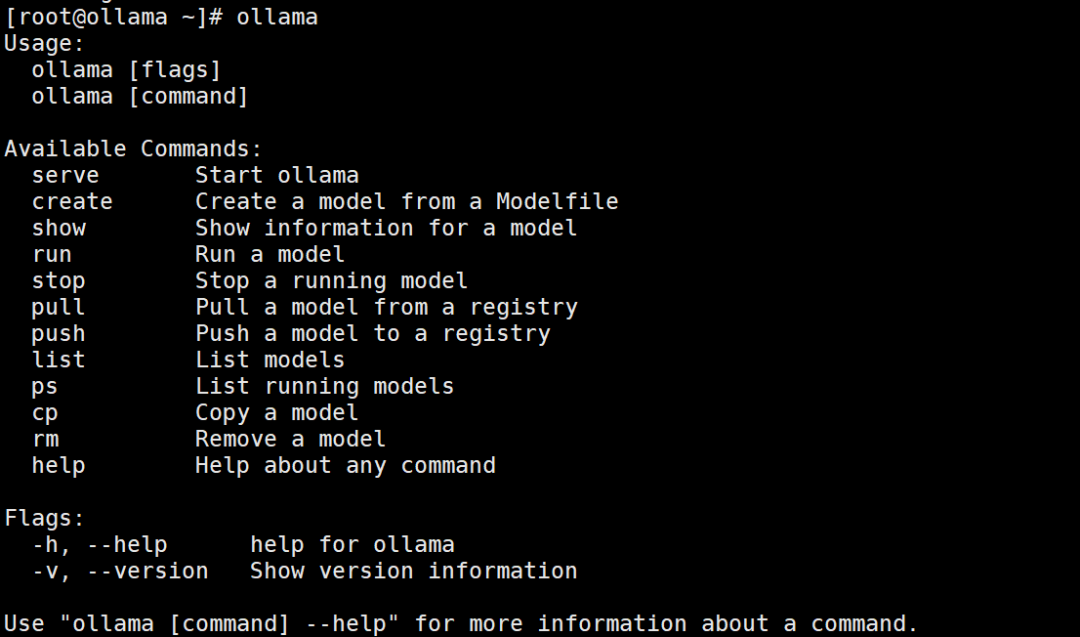

命令行中输入Ollama命令,如果出现以下信息,则表示安装成功

ollama

1.24-6.png

1.24-6.png

1.3 创建Ollama配置文件

创建配置文件,使Ollama服务在11434端口启动。

[root@Ollama ~]# vim /etc/systemd/system/Ollama.service

配置文件内容

[Unit]Description=ollama ServiceAfter=network-online.target

[Service]Environment="ollama_HOST=0.0.0.0:11434"ExecStart=/usr/local/bin/Ollama serveUser=OllamaGroup=OllamaRestart=alwaysRestartSec=3Environment="PATH=/usr/local/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/root/bin:/root/bin"

[Install]WantedBy=default.target

1.4 加载配置并重启Ollama服务

[root@Ollama ~]# systemctl daemon-reload[root@Ollama ~]# systemctl enable ollama[root@Ollama ~]# systemctl restart ollama

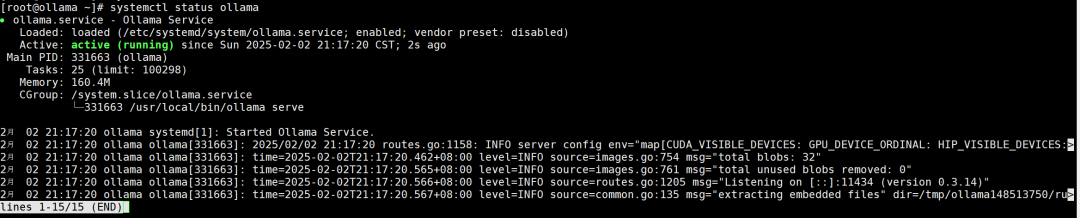

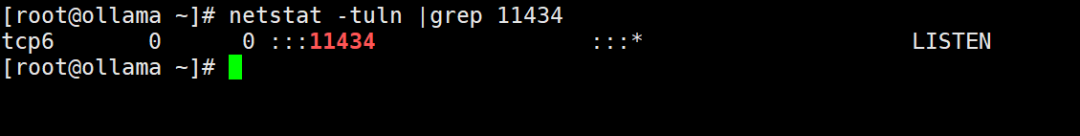

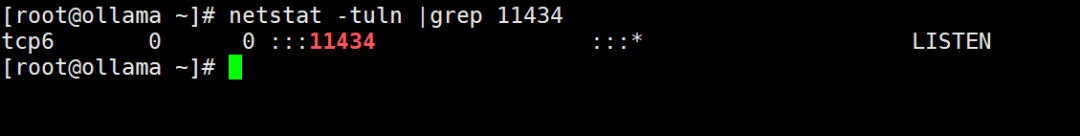

1.5 查看Ollama服务状态和端口

[root@Ollama ~]# systemctl status ollama[root@Ollama ~]# netstat -tuln | grep 11434

1.24-7.png

1.24-7.png

1.24-8.png

1.24-8.png

1.6 Ollama官网选择DeepSeek模型

1.24-9.png

1.24-9.png

1.7 下载DeepSeek模型

(说明:选择r1-7b模型是为了演示目的,想要获得更好的效果可以按需选择更大的模型)

[root@Ollama ~]# ollama pull DeepSeek-r1:7b

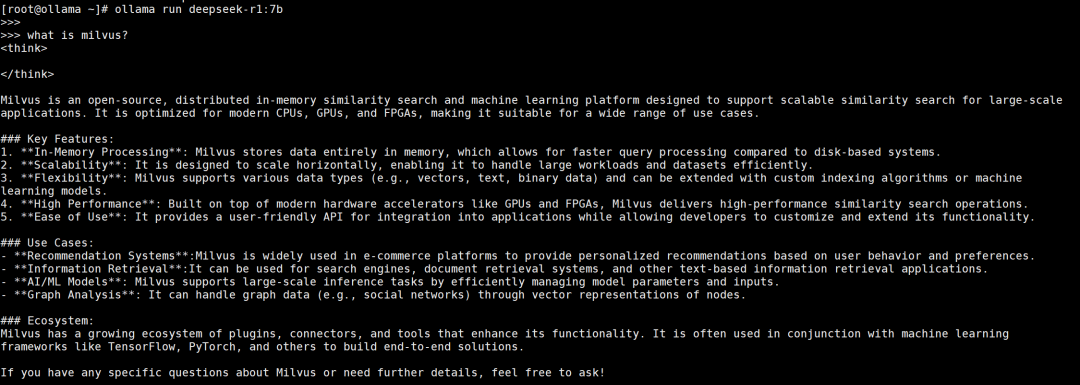

1.8 启动测试DeepSeek模型

[root@Ollama ~]# ollama run DeepSeek-r1:7b

1.24-10.png

1.24-10.png

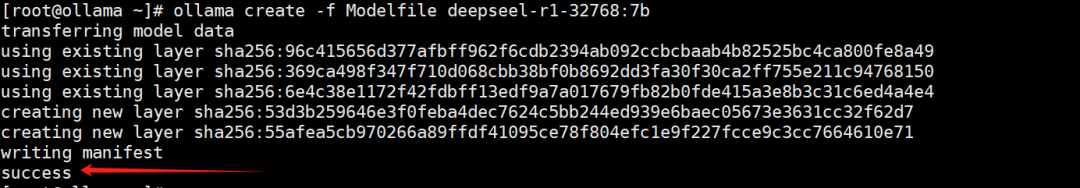

1.9 (重点)修改DeepSeek模型ctx参数

创建Modefile文件,文件名自定义。

新增上下文参数:PARAMETER num_ctx 32768 (结合上下文需求和显卡配置动态调整)

# ModelfileFROM DeepSeek-r1:7bPARAMETER num_ctx 32768

执行创建,命名新模型名称为:deepseel-r1-32768:7b

[root@Ollama ~]# ol

lama create -f Modelfile deepseel-r1-32768:7b

1.24-11.png

1.24-11.png

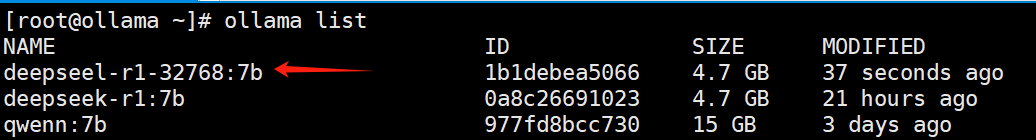

验证新命名的模型

[root@Ollama ~]# ollama list

1.24-12.png

1.24-12.png

二、Docker部署Milvus

2.1 部署Milvus环境要求

参考Milvus官网:https://milvus.io/docs/prerequisite-docker.md

必要条件:

软件要求统:docker、docker-compose

内存:至少16GB

硬盘:至少100GB

2.2 下载部署文件

[root@Milvus ~]# wget https://github.com/milvus-io/milvus/releases/download/v2.5.4/milvus-standalone-docker-compose.yml -O docker-compose.yml

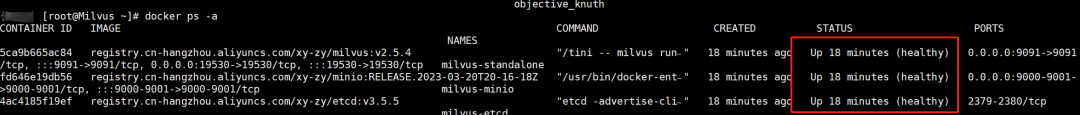

2.3 启动Milvus

[root@Milvus ~]# docker-compose up -d[root@Milvus ~]# docker ps -a

1.24-13.png

1.24-13.png

三、 VSCode 与 Roocode插件 对接本地 Ollama

3.1 下载VSCode

VSCode官网:https://code.visualstudio.com/Download

(此处省略下载安装过程)

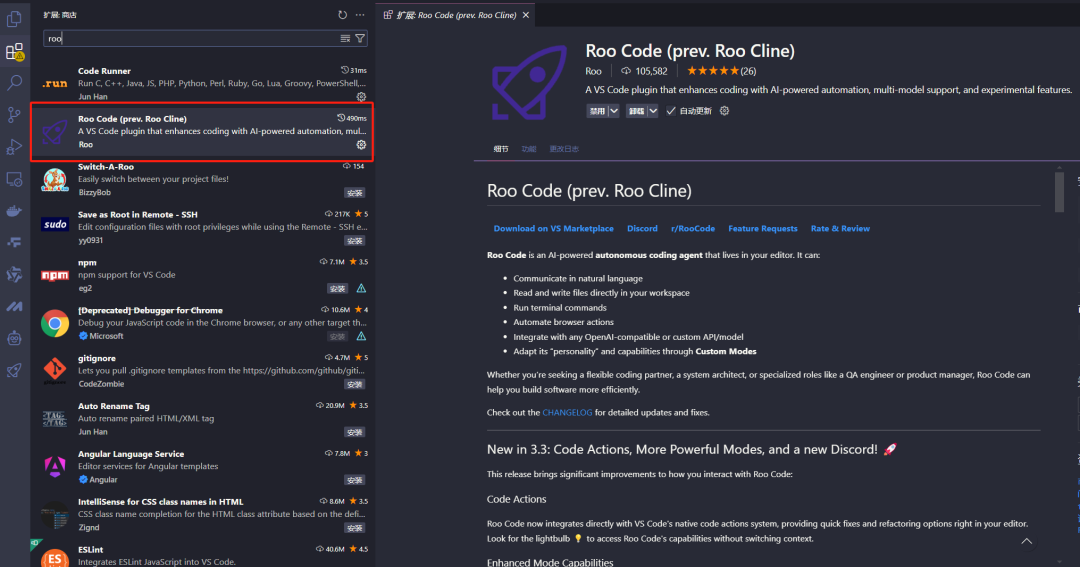

3.2 安装Roo-code插件

1.24-14.png

1.24-14.png

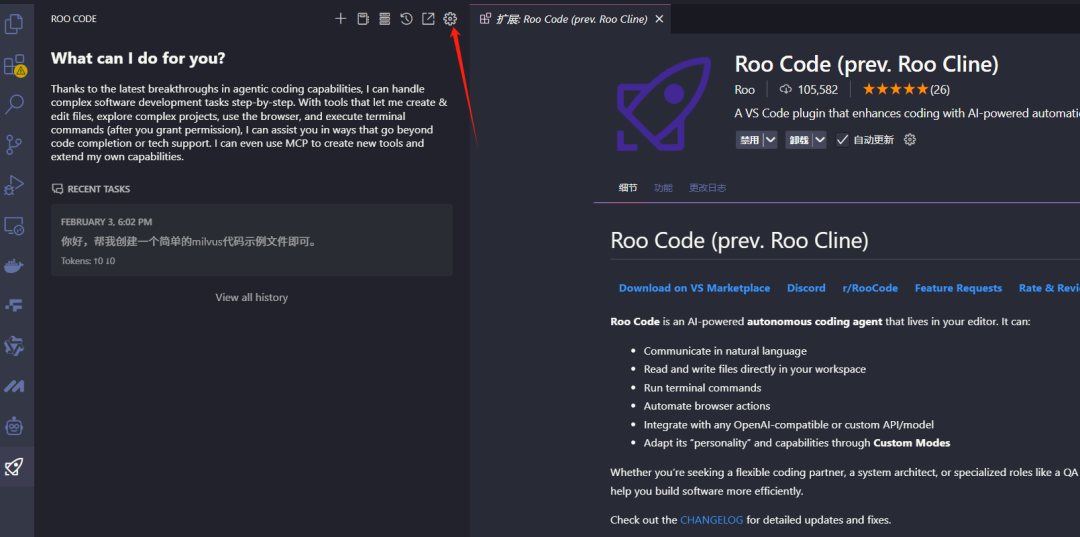

3.3 配置插件

打开设置

1.24-15.png

1.24-15.png

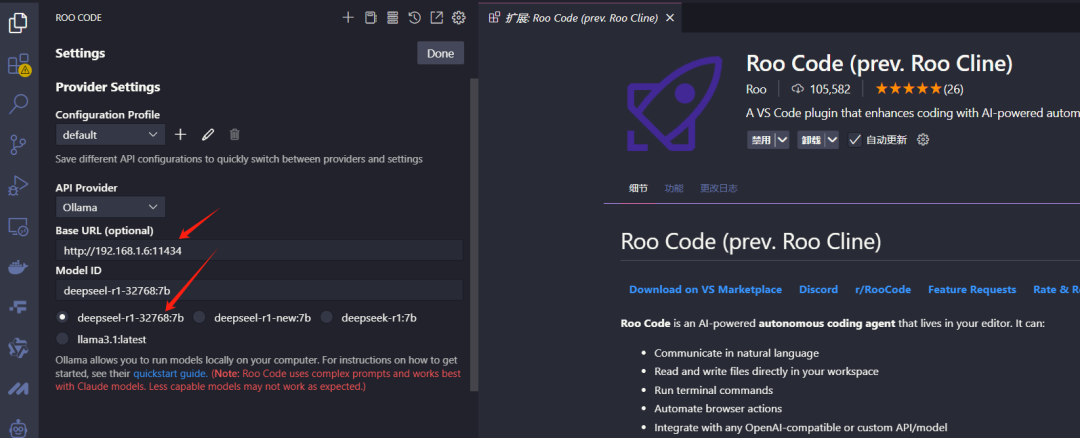

选择类型:Ollama

填入Ollama部署所在服务器IP+端口

选择DeepSeek-r1-32768:7b模型

Done

1.24-16.png

1.24-16.png

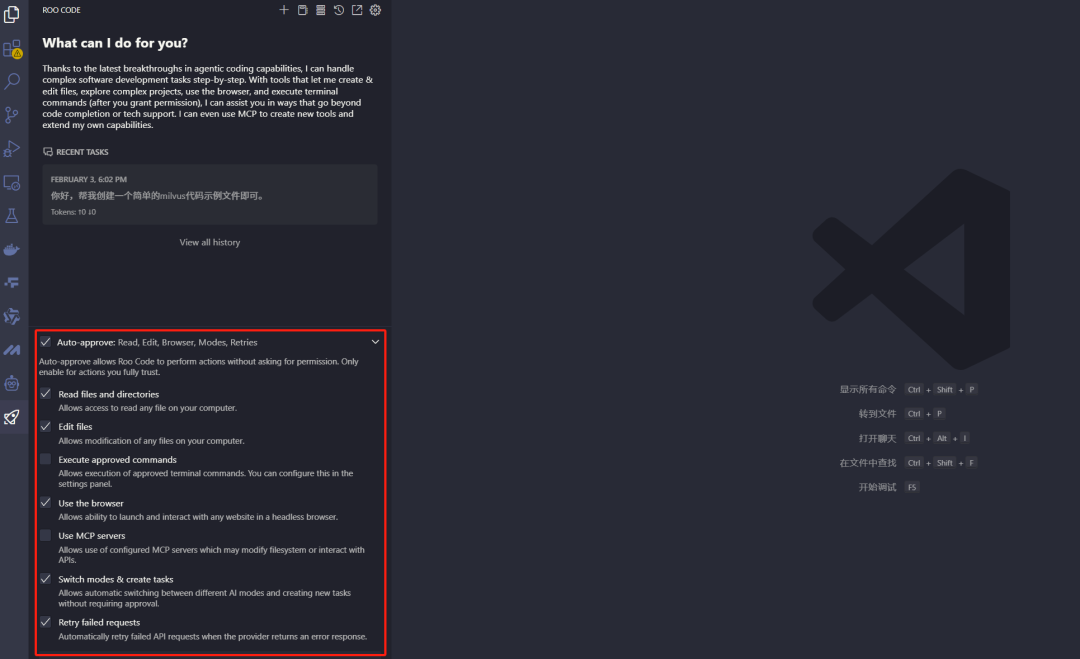

按需勾选配置,建议勾选:Read、Edit、browser、MCP

1.24-17.png

1.24-17.png

04

创建对话示例

你好,帮我创建一个简单的milvus代码示例文件即可。

1.24-18.png

1.24-18.png

05

写在最后

经过本教程的学习,相信大家已经完全掌握了如何在本地环境中部署和使用 DeepSeek + Milvus 这套 AI 搜索解决方案。我们从环境准备、组件安装到最终的实际应用,每一步都进行了详细的讲解。通过 Ollama 运行 DeepSeek、Docker 部署 Milvus,再到 VSCode 的 Roo Code 插件集成,我们成功搭建了一个完全本地化的 AI 搜索引擎。

值得一提的是,DeepSeek 作为一个开源的 AI 模型正在快速发展,其性能和功能都在不断提升。通过本地部署的方式,我们不仅可以节省 API 调用的成本,还能确保数据安全,同时获得更灵活的使用体验。随着 DeepSeek 的持续进化和社区的不断壮大,相信这套解决方案会变得更加强大和易用。

希望这篇教程能够帮助到更多想要探索 AI 技术的开发者们,期待未来DeepSeek+Milvus未来带来的更多可能性!

技术干货

如何设计一个面向开发者全生命周期成本的全托管向量检索服务产品?

作为产品的设计者和开发者,必须始终以用户为中心,积极倾听他们的需求,并集中精力降低软件开发的全链路成本,而非过度追求极致性能或过分炫技。在这种背景下,降低开发者的综合使用成本已成为 Zilliz Cloud 和开发团队过去的主要使命。

2023-7-5

技术干货

当一个程序员决定穿上粉裤子

如何找到和你时尚风格相似的明星?AI + Milvus=?

2023-8-23

技术干货

向量数据库的行业标准逐渐清晰!Vector DB Bench 正式开源!

本文将从 Vector DB Bench 的特点和优点出发,帮助开发者全面、客观、高效地评估向量数据库。

2023-6-21